안녕하세요! 메타부입니다.

이전에 한 번 설명해드렸던 Heurist라고 AI 프로젝트 기억하시나요?

이 프로젝트는 AI랑 마이닝도 출시하고 여러가지로 커뮤니티에 하잎을 붙이는 녀석이긴한데...

아직 자세한 투자액이나 공격적인 토큰출시 등등에 대해 올라온 것은 없다고 말씀드렸죠.

하.지.만...

해당 프로젝트의 WL의 가격은

아직도 이런 상황..

아무튼 이전의 노드 셋팅방법은

https://metaboo.tistory.com/61

Heurist 노드, 언제 끝날지 모르니 빨리해야돼요!

Heurist라고 AI 프로젝트가 있는데요. 이 프로젝트는 AI랑 마이닝도 출시하고 여러가지로 커뮤니티에 하잎을 붙이는 녀석이긴한데... 아직 자세한 투자액이나 공격적인 토큰출시 등등에 대해 올라

metaboo.tistory.com

위 블로그 게시글을 통해 설명드렸었습니다. 그래서 기본적인 세팅은 동일하다고 보시면 되는데요.

이번 Incentivized Testnet의 경우 이제 실제 메인넷 런칭시 획득할 수 있는 토큰을 획득할 수 있는 중요한 분기점이기 때문에 TGE를 노리고 꼭 하시면 좋겠어서 이렇게 새로 다시 작성한다고 보시면 되겠습니다!

☞신규 유입자를 포함해서 말이죠.

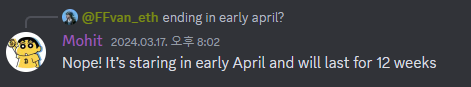

그리고 Incentivized Testnet의 경우 대략 12주가량 진행될 예정이라고는 했었구요.

갑자기 이 내용이 사라져서 이젠 얼마나 걸릴지는 모르는 상황입니다.

총 공급량의 5%를 이번 인센티브 테스트넷을 통해 지급한다고 하니까 달달할 가능성이 높은 상황입니다!

☞왜냐면 이정도의 토큰을 먹을려면 GPU를 돈내고 돌려야되는데 진입장벽도 높아서 쉽게 접근이 불가능하니까요!!

아무튼 그러하니 참고하시구요.

기본적인 GPU 대여는 Vast.ai에서 진행하니 참고하세요!

그럼 GPU서버 대여부터 가봅니다!

※중요사항

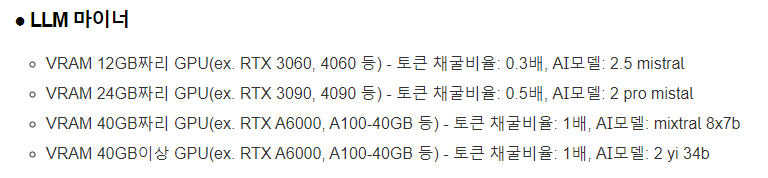

Heurist의 테스트넷이 시작되면서 본인의 GPU당 설정방식과 토큰 채굴비율 등등이 세분화되었습니다.

이 점 참고하셔서 GPU 를 임대하시기 바랍니다.

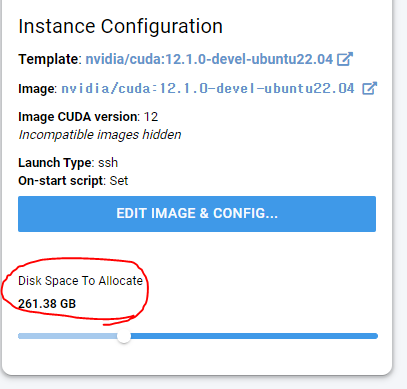

용량은 최소 250GB 정도 필요합니다.

☞근데, 설치하고나니 100GB 조금 넘게 잡더라구요? 그러니까 여기에 뭔가 더 설치해서 돌리실 예정이 아니라면 Heurist만 이용할 걸 생각해서 조금 널널하게 150~200GB정도로만 해주셔도 무방할 듯 합니다.

● LLM 마이너

- VRAM 12GB짜리 GPU(ex. RTX 3060, 4060 등) - 토큰 채굴비율: 0.3배, AI모델: 2.5 mistral

- VRAM 24GB짜리 GPU(ex. RTX 3090, 4090 등) - 토큰 채굴비율: 0.5배, AI모델: 2 pro mistal

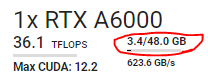

- VRAM 40GB짜리 GPU(ex. RTX A6000, A100-40GB 등) - 토큰 채굴비율: 1배, AI모델: mixtral 8x7b

VRAM 40GB이상 GPU(ex. RTX A6000, A100-40GB 등) - 토큰 채굴비율: 1배, AI모델: 2 yi 34b삭제됐습니다.

● SD 마이너

- VRAM 12GB이상이면 모두 가능

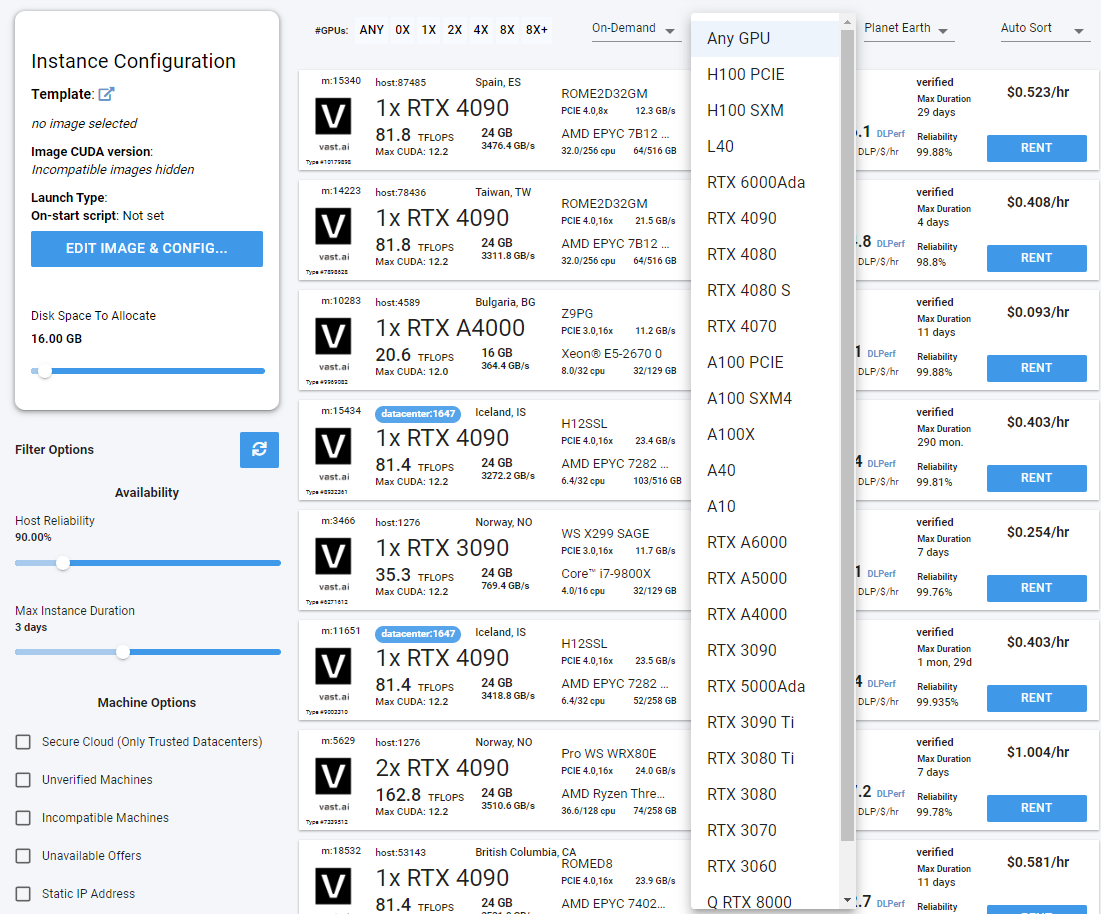

그리고, 아래의 Vast이용하기에서 저는 RTX A6000을 임대하고 싶어서 Vast.ai를 통해 아래와 같이 임대했으니 참고하세요!

1. Vast.ai 이용하기

https://cloud.vast.ai/?ref_id=120342

Vast.ai | Console

cloud.vast.ai

위 링크를 통해 사이트 접속해주시구요.

그럼 이런 창으로 접속이 될텐데 우측의 Sign In을 눌러주세요.

그 다음 Create Account를 눌러서

구글로 가입해주셔도 되구요. 그다음 로그인해주세요.

그럼 이렇게 우측에 로그인된게 확인됩니다.

이제 화면에서 Any GPU라고 적힌 부분을 눌러서

원하는 GPU로 선택하시면 되구요.

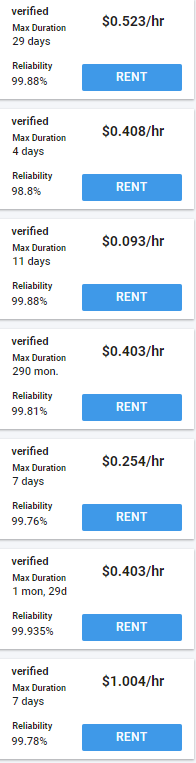

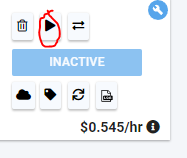

우측의 이건 각 GPU별 시간당 금액이니 저렴한걸로 선택하시면 될 것 같습니다.

참고로 Max Duration은 한 번 유지보수를 위해 재기동되는 날까지 남은 기한이기 때문에 넉넉한 걸로 골라주셔야 됩니다.

아니면 다시 재기동해야될 수 있어요.

일단 저는 A6000으로 설정을 바꿨구요.

지난 번 Heurist작업을 위해 최소 250GB가 필요했기 때문에 이번에도 그만큼의 용량이 남는 것들 위주로 선택했습니다.

선택을 완료하시면

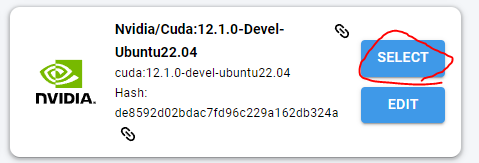

다양한 Template을 선택하라면서 구경하실 수 있는데 그 중 아래로 내려서 Popular로 가주신 뒤

동그라미 친

- Nvidia/Cuda:12.1.0-Devel-Ubuntu22.04

의 Select를 눌러주세요.

☞그래야 Cuda와 환경설정이 가능합니다.

선택은 Select를 눌러주시면 되고

위와 같이 설정을 완료하신다면

이제 본인이 임대할 GPU를 자세히 보시면 정보들을 확인하실 수 있습니다.

- GPU RAM 용량

- CPU 정보 및 RAM 용량

- SSD 정보 및 용량

- 시간당 가격

- 인증까지 남은 기한(이후 종료되어 재인증 될때까지 대기상태 돌입) - 위의 Max Duration 설정값에 의해 필터링된 항목들의 Max Duration이다.

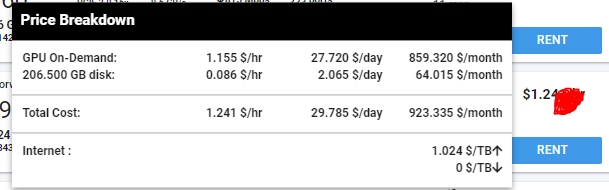

특히, 가격부분에 마우스를 가져가면 이렇게 총 비용도 확인 가능하니 임대에 참고하시면 됩니다.

이렇게 정보를 확인할 수 있기 때문에 본인에게 맞는 GPU와 성능 등을 고르시면 되겠습니다.

이제 용량도 대충 맞게끔 바꿔주시고

RENT를 누르면 결제할 카드 입력하라고 나오니까 ADD CARD 눌러서 카드 추가해주시고 결제도 진행해주세요.

그 다음 다시 RENT를 누르면

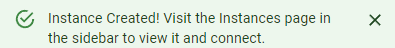

이런 메세지가 뜨는데요.

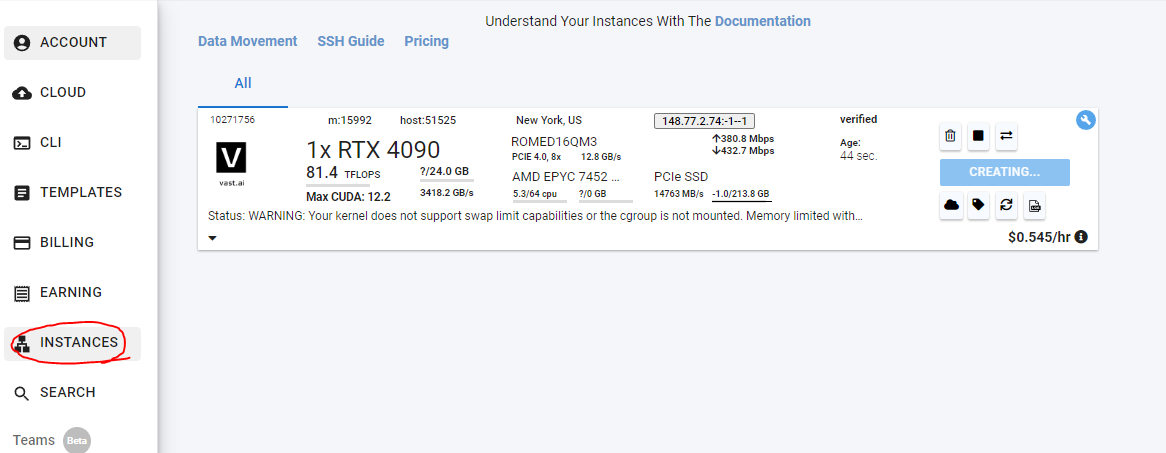

왼쪽의 INSTANCES를 누르면 이렇게 생성완료된 GPU가 보이게 됩니다.

자 이제 Connect를 눌러주시고

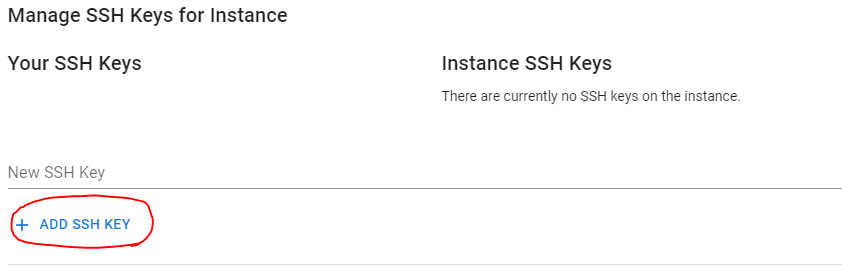

동그라미 친 ADD SSH KEY눌러주시면

이런 SSH 명령어가 나오는데요.

동그라미친 Direct ssh connect의 SSH 명령어를 메모장에 복사해주세요.

그리고

중지버튼을 눌러서 일단 돈 안빠져나가게 중지해줍시다.

2. Putty로 서버 연결하기

이제 putty를 다운받아줍시다.

https://www.chiark.greenend.org.uk/~sgtatham/putty/latest.html

Download PuTTY: latest release (0.80)

This page contains download links for the latest released version of PuTTY. Currently this is 0.80, released on 2023-12-18. When new releases come out, this page will update to contain the latest, so this is a good page to bookmark or link to. Alternativel

www.chiark.greenend.org.uk

위 링크로 접속하신 다음

이 내용 중 본인에게 맞는걸 다운받고 putty를 설치해주세요.

☞대부분은 맨 위의 64-bit x86입니다.

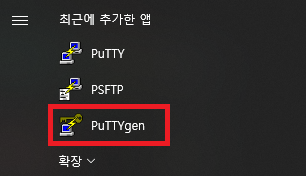

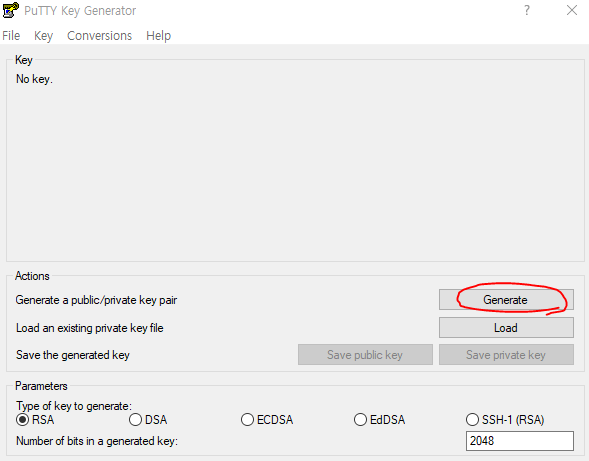

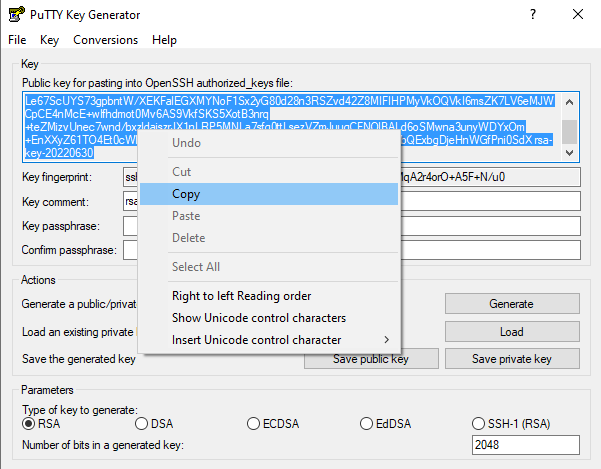

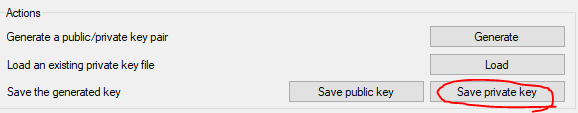

설치 완료가 되었다면 PuTTYgen이라는 프로그램을 열어주세요

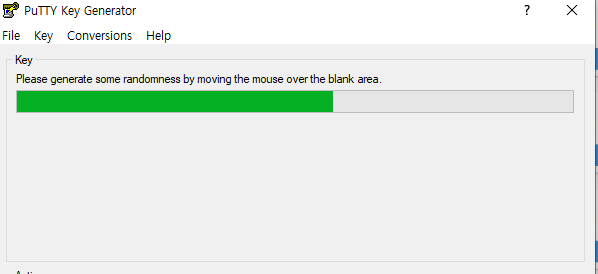

그 다음 Generate버튼을 눌러서 좀 기다리시면

이런거 나오는데 마우스 막 움직이면서 기다리시면 됩니다.

그러면 이렇게 나타나는데요.

이 키를 이런식으로 복사해줍시다.

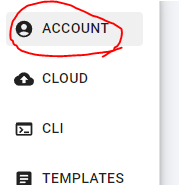

복사하셨으면 Vast.ai 사이트 왼쪽의

Account를 눌러주시면

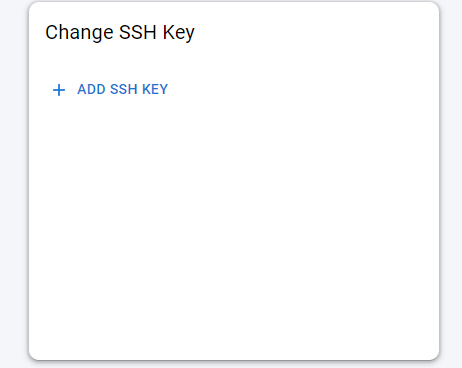

Change SSH Key라고 있습니다. 여기의 Add ssh key를 눌러주세요.

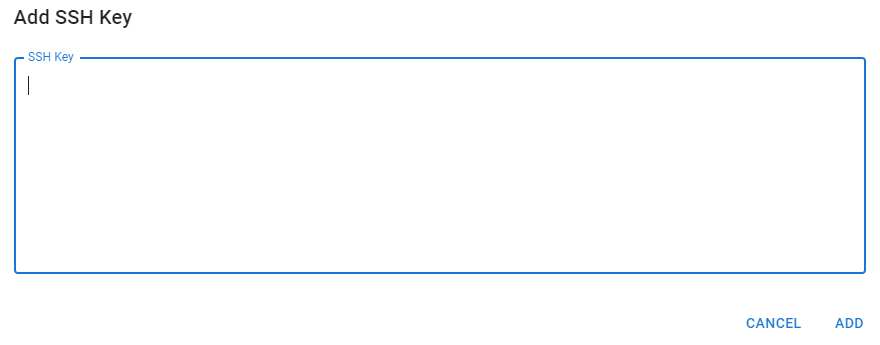

그리고 이 SSH key라는 빈칸 부분에 아까 PuTTYgen에서 생성해서 복사했던 SSH key를 붙여넣고

그리고 멈췄던 instance를 재생버튼을 눌러서 실행해주세요.

그리고

그리고 멈췄던 instance를 재생버튼을 눌러서 실행해주세요.

그리고

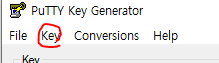

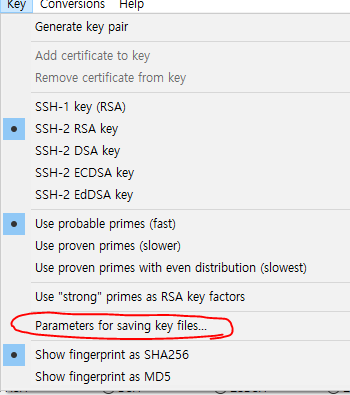

key를 누르면

이 parameters 뭐시기가 나오는데 눌러주세요.

이렇게 설정을 바꾼 뒤

Save private key를 눌러 ppk파일을 저장해줍시다.

Putty 실행해주시구요.

아까 복사했던 걸 보면

ssh -p 숫자(포트번호) root@IP주소 -L 8080:localhost:8080이런 형식으로 되어있을겁니다.

이제

이렇게 그대로 옮겨서 Saved Session에 이름을 작성한 뒤 Save버튼을 눌러주시구요.

Credentials 경로로 가서 Browse를 눌러 저장했던 ppk파일을 선택해주신 뒤 open 버튼을 눌러주시면 됩니다.

☞순서 꼭 지켜야 접속됩니다.

다시 한 번 Putty로 접속하는 순서 알려드립니다.

- Putty를 킨다.

- 본인이 접속하기 위해 save한 서버선택 후 Load버튼 클릭한다.

- 이후 왼쪽의 Connection - SSH - Auth - Credentail을 누른다.

- 우측의 Private Key file for authentication의 Browse..를 누른다.

- 저장했던 ppk 파일을 선택해준다.

- credential 창 아래의 open 버튼을 눌러준다.

만약 위와 같이 했는데도

이런 에러가 뜬다면

Vast의 Instance메뉴에서 Open SSH Interface를 열고 PuttyGEN으로 만든 key를 Instance SSH Key에도 붙여넣으시면 실행된다고 합니다!

그럼 이런 창이 뜨는데 accept를눌러주세요.

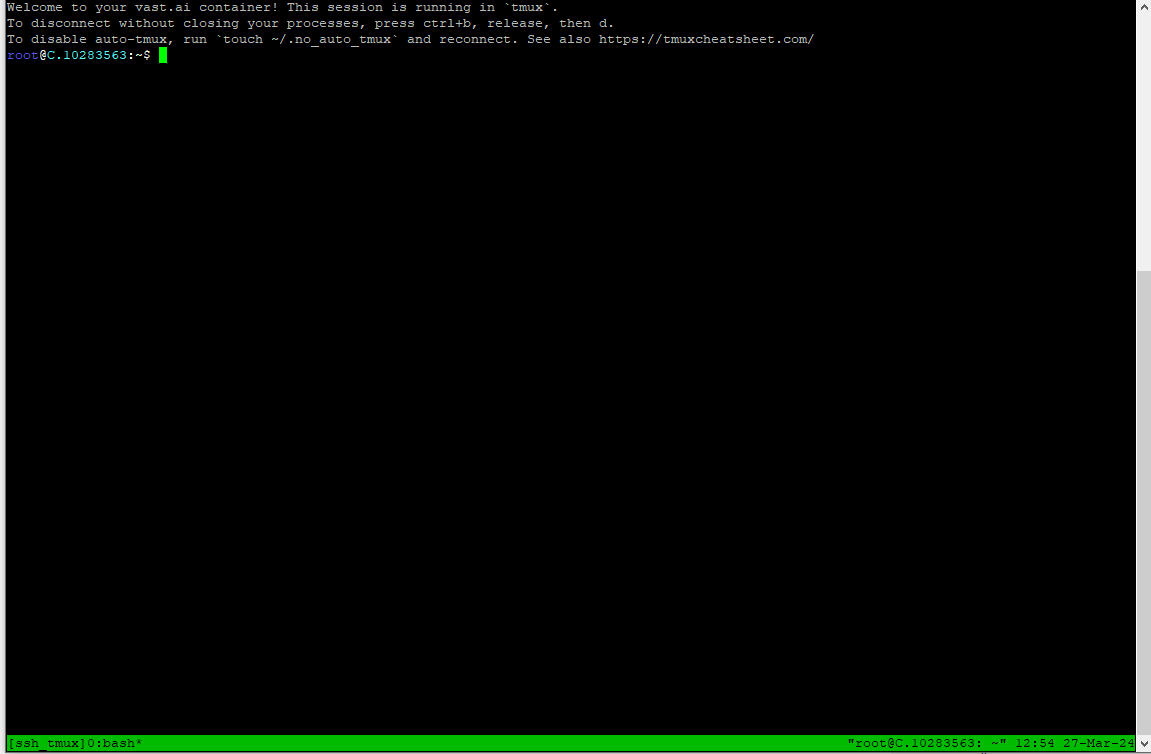

그럼 이렇게 접속 완성!

3. Heurist 노드 환경설정 체크하기

일단 기초 설정 다운로드부터 해줍시다.

sudo rm /var/lib/dpkg/info/*

sudo dpkg --configure -a

sudo apt-get update

sudo apt update

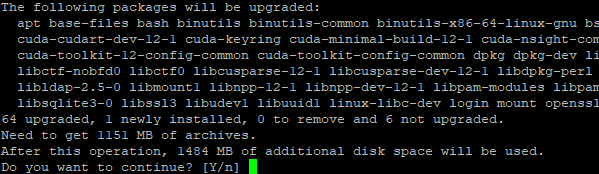

sudo apt -qy install wget curl git jq lz4 build-essential nano위 명령어 순서대로 입력해주시구요.

sudo apt upgrade

위 명령어 실행해주 신뒤

이렇게 나오면 끝!

이제

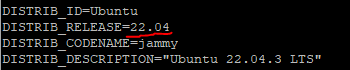

cat /etc/*release위 명령어 입력하면

리눅스의 버전을 확인할 수 있구요.

nvcc --version을 입력하면

CUDA의 버전을 확인할 수 있고

sudo nvidia-smi위 명령어를 입력하면

Nvidia의 버전을 확인할 수 있습니다.

버전이 확인된다는 것은 설치가 다 완료가 되어있다는 소리니까 이제 바로 PyTorch 설치해줍시다.

4. Heurist 노드 환경설정 설치하기

이제 그럼 본격적으로 환경설정을 위해 체크해줍시다.

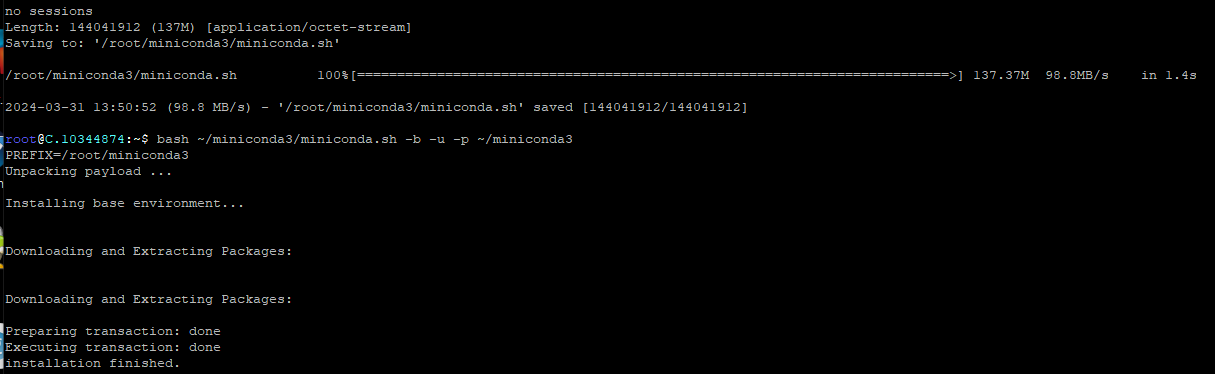

이제 PyTorch를 다운받기 위해 miniconda를 설치해줄거에요.

mkdir -p ~/miniconda3

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh -O ~/miniconda3/miniconda.sh

bash ~/miniconda3/miniconda.sh -b -u -p ~/miniconda3

rm -rf ~/miniconda3/miniconda.sh

위 명령어 그대로 한 줄씩 복사해서 수행해주시구요.

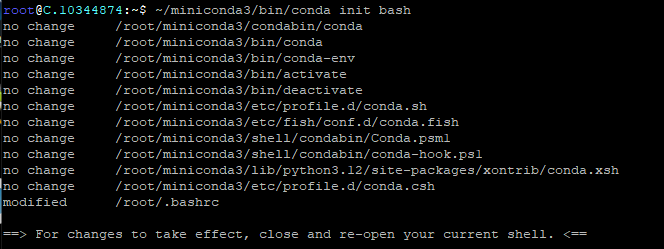

~/miniconda3/bin/conda init bash

위 명령어도 수행해주세요.

그리고 이제

source ~/.profile위 명령어 입력해주시면 됩니다.

그러면

앞에 저런식으로 (base)가 나타날겁니다.

여기까지 되셨으면

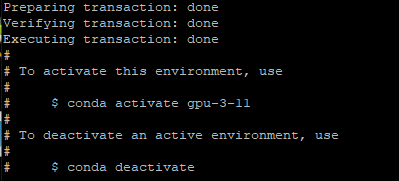

conda create --name gpu-3-11 python=3.11

위 명령어 입력하시고

위와 같이 완료가 되었으면

conda activate gpu-3-11이거 해주시면

이렇게 바뀝니다.

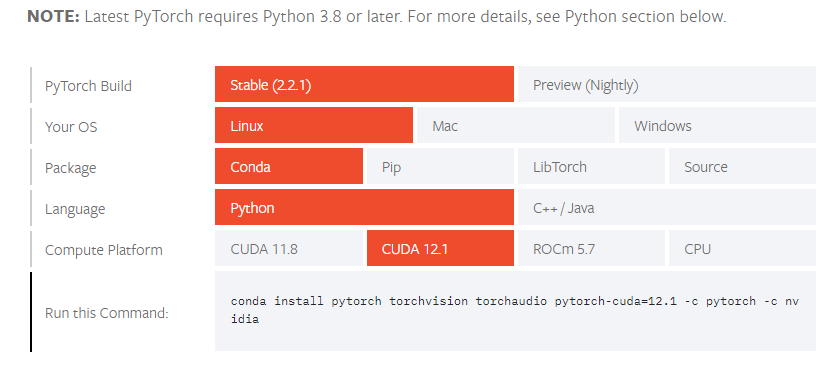

이번엔 pyTorch를 설치해줘야돼요. 이녀석은 딥러닝 필수 오픈소스라 설치해줘야됩니다.

https://pytorch.org/get-started/locally/

Start Locally

Start Locally

pytorch.org

위 사이트 접속하신 뒤

이렇게 눌러야 되구요. 그렇게 나오는 Run this Command를 복사해서 붙여넣고 실행해주세요.

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia귀찮으신 분들은 위 명령어 복붙 ㄱㄱ!

☞만약 PyTorch나 CUDA의 버전이 바뀌면 위와 같은 방식으로 접속해서 명령어 알아내시면 됩니다.

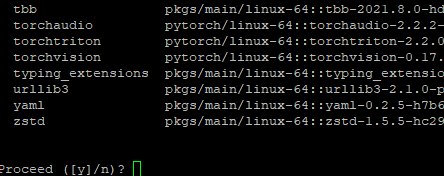

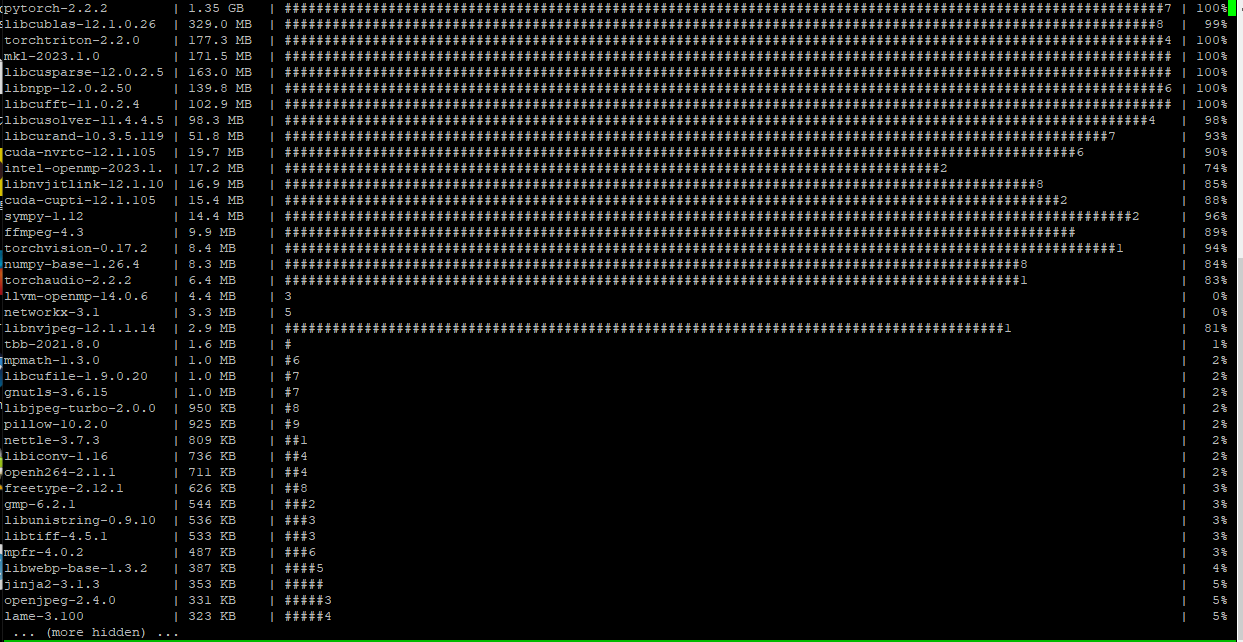

위와 같이 뜨면서 설치해주시고

그럼 이렇게 알아서 설치가 진행되고.. 좀 기다리시면

이렇게 뜨면서 끝!

여기까지 됐으면 이제 마지막 설치입니다.

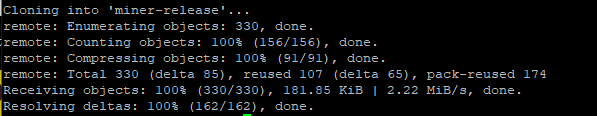

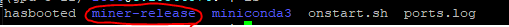

git clone https://github.com/heurist-network/miner-release.git위 명령어 그대로 입력해서 heurist의 깃을 다운받아줍시다.

그럼 이렇게 나타날테고

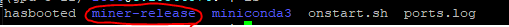

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

이제 환경설정해주러 갑시다.

5. Heurist LLM 노드 돌리기 - 환경설정/수행편

여기까지도 오래걸렸을텐데 모두 수고많으셨습니다. 이제 환경설정해볼게요.

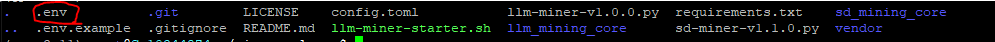

cd miner-release위 명령어 눌러주시구요.

cp .env.example .env위 명령어를 입력한 뒤

nano .env

로 창을 띄웁니다.

MINER_ID_0=0x로 시작하는 본인EVM주소위 내용을 입력해주세요.

참고하시면, 본인이 쓰는 주소하셔도 되고 새로만든 지갑의 주소하셔도 되지만 화리는 아마 저 지갑주소로 들어갈겁니다.

☞만약 GPU가 여러개면 MINER_ID_0, MINER_ID_1, MINER_ID_2... 이런식으로 갈텐데.. 1개만 했으니 0만 있으면 됩니다.

아무튼 완료되셨다면 Ctrl+X, Y, 엔터를 순차적으로 눌러주세요.

그리고

ls -a위 명령어 입력해서

이렇게 .env 파일이 생성됐으면 됩니다.

pip install -r requirements.txt이제 위 명령어 입력해서 요구사항을 설치해줍니다.

꼭 현재의 경로가 miner-release에 있는 상태여야 됩니다.

위 내용까지 되셨으면 이제

sudo apt-get install screen위 명령어를 입력해서 screen을 설치해주시구요.

이제 2가지 채굴(mining)으로 나뉩니다.

LLM 노드와 SD(Stable Diffusion) 노드 두 개에 따라 포인트가 채굴되는 방식이구요.

채굴된 포인트 당 전환되는 TGE 정보는 추후 공개될 예정이라고 합니다.

위 표는 각 노드에 따른 필요 GPU 내용이니 참고하세요!

5-0. 업데이트 되었을 경우 업데이트 하는 방법

종종 업데이트가 되는 경우가 많습니다. 그 경우에는 아래의 방법대로 해주시면 됩니다!

일단 스크린에 돌아가는 녀석들부터 종료해줘야되니까

//SD-Miner 종료해주기

Ctrl + A + D

screen -r heurist

Ctrl + C

//LLM 종료해주기

Ctrl + A + D

screen -r llm

Ctrl + C위 명령어를 순서대로 입력해주신 뒤 Ctrl + A + D로 스크린 빠져나와주세요.

그 다음

cp ~/miner-release/.env ~/.env

cd ~

rm -rf miner-release위 명령어를 차례차례 수행해주시구요.

git clone https://github.com/heurist-network/miner-release.git위 명령어 그대로 입력해서 다시 heurist의 깃을 다운받아줍시다.

그럼 이렇게 나타날테고

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

그리고

cp ~/.env ~/miner-release/.env위 명령어를 다시 입력해주시면 환경설정파일까지 모두 복사 붙여넣기 완료!

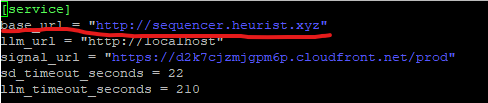

그리고 아시아에 거주하시는 분들이라면 좀 더 빠르게 채굴될 수 있도록 홍콩서버를 이용하라고 합니다.

☞이 부분에 대한 변경은 필수는 아닙니다. 만약 에러난다면 원래 base_url주소로 이용해주셔야됩니다.

nano ~/miner-release/config.toml여기에 들어가서

위에 보이는 base_url부분을

http://sequencer-hk.heurist.xyz/

위 주소로 변경하고 Ctrl+x, y, 엔터를 입력해서 저장해주시면 됩니다.

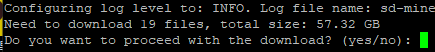

5-1. Stable Diffusion Mining 하는 방법

screen -S heurist를 입력해줍시다.

conda activate gpu-3-11

위 명령어로 앞의 base를 gpu-3-11로 다시 바꿔주시고

cd miner-release입력해서 경로 바꿔주시고

ls를 입력하시고

위의 파일이 있는지 확인하세요. (5월 13일 기준 v1.3.0.py)

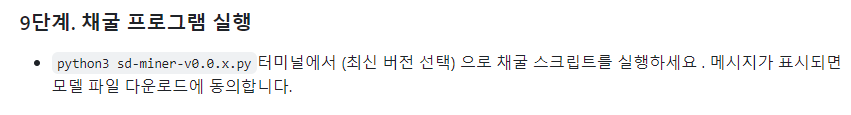

python3 sd-miner-v1.3.0.py이제 위 명령어를 입력해줍시다.

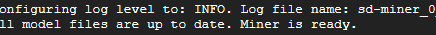

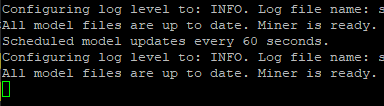

이렇게 나오는거 좀 걸리고, 그 뒤에 알아서 돌아가기 시작할테니 Ctrl+A+D로 빠져나와주세요.

혹시 다시 저 화면에 들어가고 싶으시다면

screen -r heurist위 명령어를 입력해주시면 들어가집니다.

근데 위 내용처럼 안나오고 막 이상하게 뒤죽박죽 되어있을 수도 있는데요.

그래도 어쨌든 위쪽에 "Miner is ready"라는 글자가 보이면 정상적으로 끝난거니 걱정마시구요.

그러면 Ctrl+Z를 통해 한 번 종료해주신 뒤

clear를 한 번 입력해주시면 깔끔해집니다.

그리고 이번에는

python3 sd-miner-v1.3.0.py --exclude-sdxl를 입력해줍시다.

☞뒤에 --exclude-sdxl이 붙어야 LLM이랑 동시에 돌릴 수 있다.

위 방법이 이 9단계까지 완료한 SD 마이너의 노드 구축 방법입니다!

☞참고로 SD-mining의 경우엔 트래픽이 엄청 많이 발생해서 VPS에 따라 접속막힐 수도 있습니다.

그래서 만약 SD-Mining과 LLM을 같이 돌리고 싶으시다면

python3 sd-miner-v1.3.0.py --exclude-sdxl위 명령어로 실행해주시면 됩니다!

☞개인적으론 이 명령어를 통해 SD-Miner 돌리시는거 추천드립니다.

이제 SD-Miner와 함께 LLM을 돌리실 분들은 Ctrl+A+D를 통해 빠져나와주세요!

만약 안돌리실 거라면 끄는 방법은 Ctrl+A+D를 통해 빠져나오신 뒤

sudo screen -X -S heurist kill해주시면 됩니다.

5-2. LLM Mining 하는 방법

이제 빠져나오셨으니

screen -S llm를 입력해줍시다.

그리고

conda activate gpu-3-11

위 명령어로 앞의 base를 gpu-3-11로 다시 바꿔주시고

cd miner-release입력해서 경로 바꿔주시고

chmod +x llm-miner-starter.sh위 명령어까지 해주시구요.

./llm-miner-starter.sh AI모델ID --miner-id-index 0 --port 8000 --gpu-ids 0마지막으로 위 명령어의 "AI모델ID"라는 부분만 변경한 뒤 수행해주시면 되는데요.

상세 설정은 다음과 같습니다.

--miner-id-index: .env 파일에서 본인의 miner-id의 번호. 1개만 입력했으면 0이 기본값이다.

--port: 본인이 가상서버에서 AI돌릴 포트의 번호. 기본값은 8000이고, 8001, 8002등등 변경하고 싶을 때만 변경하면 된다.

--gpu-ids: 본인이 서버에 GPU가 여러대면 그 중 몇 번째의 GPU를 쓸건지 설정가능하다. 그런거 없을테니 0이 기본값이다.하지만, 우리는 위와 같은 대부호가 아니니 기본값으로만 돌리겠습니다.

그리고 "AI모델ID"부분은 아까 상단에서 언급했던

이 부분입니다.

따라서, 아래와 같습니다.

◎ VRAM 12GB짜리 GPU (ex. RTX 3090, 4060 등) 삭제됐습니다.

◎ VRAM 24GB짜리 GPU 이용자 (ex. RTX 3090, 4090 등)

./llm-miner-starter.sh openhermes-2-pro-mistral-7b위에껀 기본이지만

./llm-miner-starter.sh dolphin-2.9-llama3-8b신규 추가 되었습니다. 이게 훨씬 더 많은 포인트를 획득할 수 있다고 하니 참고하세요.

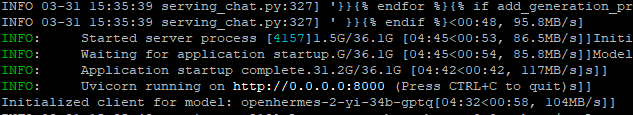

◎ VRAM 40GB짜리 GPU 이용자 (ex. RTX A6000, A100-40GB 등)

./llm-miner-starter.sh openhermes-mixtral-8x7b-gptq◎ VRAM 40GB이상 GPU 이용자 (ex. RTX A6000, A100-40GB 등) 삭제됐습니다.

위 명령어 중 하나를 복사해서 입력하시면 됩니다.

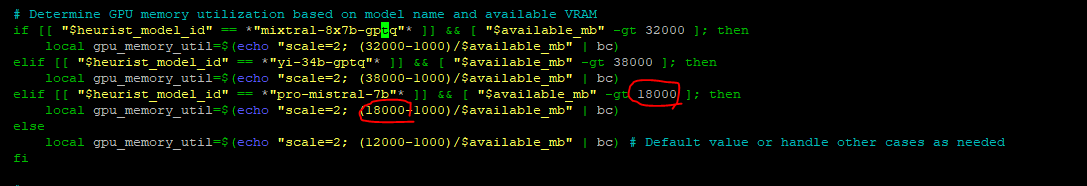

참고로, 4090에서 pro-mistral이 잘 안돌아간다면

nano ~/miner-release/llm-miner-starter.sh를 입력해서

아래로 쭈우우욱 내려서 나오는 16000을 18000으로 수정해주면 됩니다.

본인의 GPU 서버의 VRAM은

동그라미친 부분을 통해 확인이 가능합니다.

만약

이런 에러가 뜬다면

sudo apt update && sudo apt install bc

를 입력해주고

sudo apt update || sudo apt upgrade || sudo apt install software-properties-common || sudo add-apt-repository ppa:deadsnakes/ppa ||

sudo apt install python3-venv

위 명령어를 입력해준 뒤 다시

◎ VRAM 24GB짜리 GPU 이용자 (ex. RTX 3090, 4090 등)

./llm-miner-starter.sh openhermes-2-pro-mistral-7b위에껀 기본이지만

./llm-miner-starter.sh dolphin-2.9-llama3-8b신규 추가 되었습니다. 이게 훨씬 더 많은 포인트를 획득할 수 있다고 하니 참고하세요.

◎ VRAM 40GB짜리 GPU 이용자 (ex. RTX A6000, A100-40GB 등)

./llm-miner-starter.sh openhermes-mixtral-8x7b-gptq

위 부분 중 하나를 입력해줍니다.

그러면

이렇게 돌아가다가

이런거 설치한다고 뜨니 기다리주시고

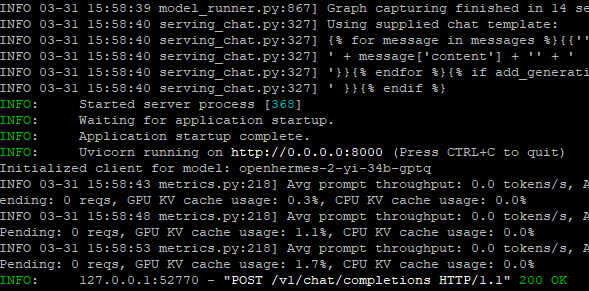

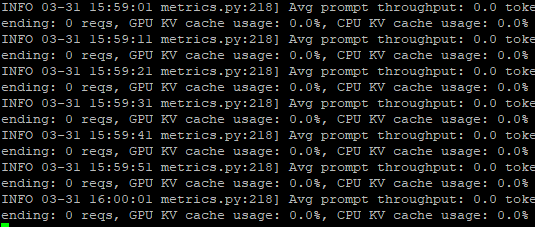

그래도 어쨌든 위쪽에 " INFO와 함께 initialized clinet for model"라는 글자가 보이면 정상적으로 끝난겁니다.

위 내용처럼 정상적으로 작동되는게 확인되셨으면

이제 Ctrl+A+D로 빠져나와주시고 창 닫아주시면 끝!!

만약 다시 접속해서 잘 돌아가나 확인하고 싶으시다면

screen -r llm위 명령어를 입력하시면 되고

사이트에서 확인할 경우엔

https://www.heurist.ai/mining

위 사이트 들어가서 지갑연결하시면 됩니다.

※ 참고로

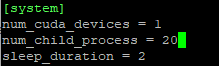

nano ~/miner-release/config.toml여기에 들어가서

위에 보이듯이 num_child_process를 2에서 20으로 변경하면 훨씬 더 많은 포인트를 채굴할 수 있다고 합니다.

☞휴리스트 측에서 조치를 취해줬고, num_child_process의 값을 2~5정도로 낮은 수치로 했을 때 포인트를 획득할 수 있도록 변경했습니다. 변경하신 분은 다시 바꿔주세요!

여기까지가 Incentivized Testnet의 LLM Miner 수행하는 방법이었습니다.

※ 휴리스트 업데이트 하는 방법!

cp ~/miner-release/.env ~/.env

cd ~

rm -rf miner-release위 명령어를 차례차례 수행해주시구요.

git clone https://github.com/heurist-network/miner-release.git위 명령어 그대로 입력해서 다시 heurist의 깃을 다운받아줍시다.

그럼 이렇게 나타날테고

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

그리고

cp ~/.env ~/miner-release/.env위 명령어를 다시 입력해주시면 환경설정파일까지 모두 복사 붙여넣기 완료!

그리고나서 스크린부터 다시 생성해서 해주시면 됩니다.

screen -r llm입력하신 뒤 Ctrl+C로 종료한 번 해주시고

cd ~

cd miner-release입력해 주신 뒤

위 명령어 중 맞는 것 하나 실행. 그 다음 Ctrl+A+D 입력 후

screen -r heurist입력 후 마찬가지로 Ctrl+C 한 번 입력해준 뒤

cd ~

cd miner-release입력하고

python3 sd-miner-v1.3.0.py --exclude-sdxl입력해서 실행해주시면 됩니다.

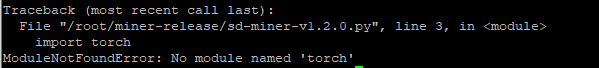

만약

이런 에러가 뜬다면

conda activate gpu-3-11

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia이 명령어 다시 입력해주시고 다시 실행해주시면 됩니다.

근데도 만약 이런 에러가 뜬다면

pip install -r requirements.txt이 명령어도 다시 입력해주신뒤 다시 실행해주시면 됩니다.

여기가지가 Heurist의 Incentivized Testnet 노드 작업방법이었습니다!

인센티브 테스트넷이라 포인트가 나중에 토큰으로 변환될 예정이니까 에어드랍 작업으로 하시면 좋을 듯 하구요.

작업하다 막히거나 모르시는 부분이 발생한다면 댓글이나 텔레그램을 통해 질문주시면 알려드릴게요!

소식과 내용을 빠르고 다양하게 접하고 싶으시다면 아래 그림(텔레그램)을 클릭해주세요!!

'크립토 에어드랍 작업 > 노드 운용하기' 카테고리의 다른 글

| 0G 테스트넷 노드 돌려보자! (Validator - 리뉴얼 완료)+ (Storage 노드는 에러 발생) (7) | 2024.04.13 |

|---|---|

| Vast.ai를 활용한 GPU서버 임대하는 방법!! Feat.AI Node (26) | 2024.04.02 |

| 바이낸스가 투자한 Nimble, 노드 돌려보기! Feat. Vast.ai (5) | 2024.03.28 |

| Heurist 노드, 언제 끝날지 모르니 빨리해야돼요! (75) | 2024.03.18 |

| 다시 돌아온 Taiko 노드 완벽정리! (20) | 2024.03.10 |