Heurist 노드, 언제 끝날지 모르니 빨리해야돼요!

- 크립토 에어드랍 작업/노드 운용하기

- 2024. 3. 18.

Heurist라고 AI 프로젝트가 있는데요.

이제 인센티브 테넷입니다.

https://metaboo.tistory.com/68

휴리스트(Heurist) AI Incentivized Testnet(인센티브 테스트넷) 작업 시작!

안녕하세요! 메타부입니다. 이전에 한 번 설명해드렸던 Heurist라고 AI 프로젝트 기억하시나요? 이 프로젝트는 AI랑 마이닝도 출시하고 여러가지로 커뮤니티에 하잎을 붙이는 녀석이긴한데... 아직

metaboo.tistory.com

위 게시글이 최신이니 저기로 이동해서 참여해주세요!

이 프로젝트는 AI랑 마이닝도 출시하고 여러가지로 커뮤니티에 하잎을 붙이는 녀석이긴한데...

아직 자세한 투자액이나 공격적인 토큰출시 등등에 대해 올라온 것은 없습니다.

하.지.만...

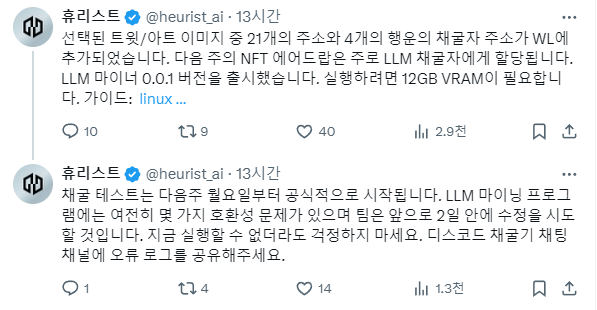

현재까지 디스코드에서 그림을 여러개 올리거나 트위터에 여러개의 Heurist에 관한 글을 쓰면 Heurist측에서 핸드픽으로 WL를 주곤 했었는데요.

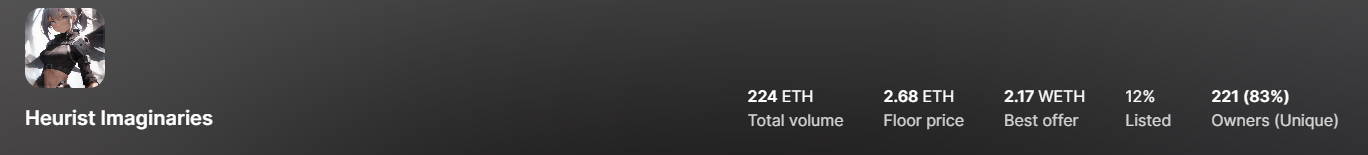

그렇게 얻은 WL로 얻을 수 있는 NFT가 있는데.. 그게

현재 이렇게 바닥가가 2이더가 넘습니다.. 오너도 별로 없구요.

인데 심지어 무료민팅이라는거~~

☞저처럼 디코나 트윗에서 찬양하는 게시글 계속 올리는거 싫어하시는 분들은 획득하기 힘들.....

아무튼 AI쪽에서는 꽤나 점점 입소문을 타고 있는 녀석인 Heurist인데요.

이 프로젝트가 이번엔 노드를 돌리면 그 안에서 WL를 주겠다고 하니까 일단 돌려보는게 좋지 않을까 싶어서요!

이렇게 월요일(18일)부터 공식적으로 시작된다고 하니까 지금부터 미리 셋팅만 해두고, 실행만 되면 될 것 같은데요.

LLM채굴하는거... 솔직히 스펙이 좀 있기는 합니다.

위에 언급된대로 12GB의 VRAM이 필요하기 때문에 기본적으로 RTX가 필요한데요.

그렇기 때문에 기본적으로는 RTX 3090 / 3080ti까지가 마지노선이고, 그 아래의 그래픽카드는 VRAM의 용량이 지원되지 않기 때문에 무리다.

심지어 HDD(SSD)용량은 최소 200GB는 있어야 된다.

라고 보시면 되겠습니다.

하지만! 우리가 누구입니까!!!!

언제나 문제에 대한 해결법은 있는 법!

바로 구글의 무료 GCP를 돌리는 것이죠!

사실 정확하게 말하면 무료는 아니지만 $300 바우처를 통해서 돌린다면 1달간은 공짜로 돌리니 그 때까진 Heurist 돌리기엔 최적이죠!

그럼 일단 GCP 가입부터 하러 가보겠습니다.

1. GCP(Google Cloud Platform) 이용하기

https://cloud.google.com/?hl=ko

https://cloud.google.com/?hl=ko

cloud.google.com

위 구글 클라우드 사이트에 접속해서

우측 상단에 이렇게 보이는 걸 클릭해주시구요.

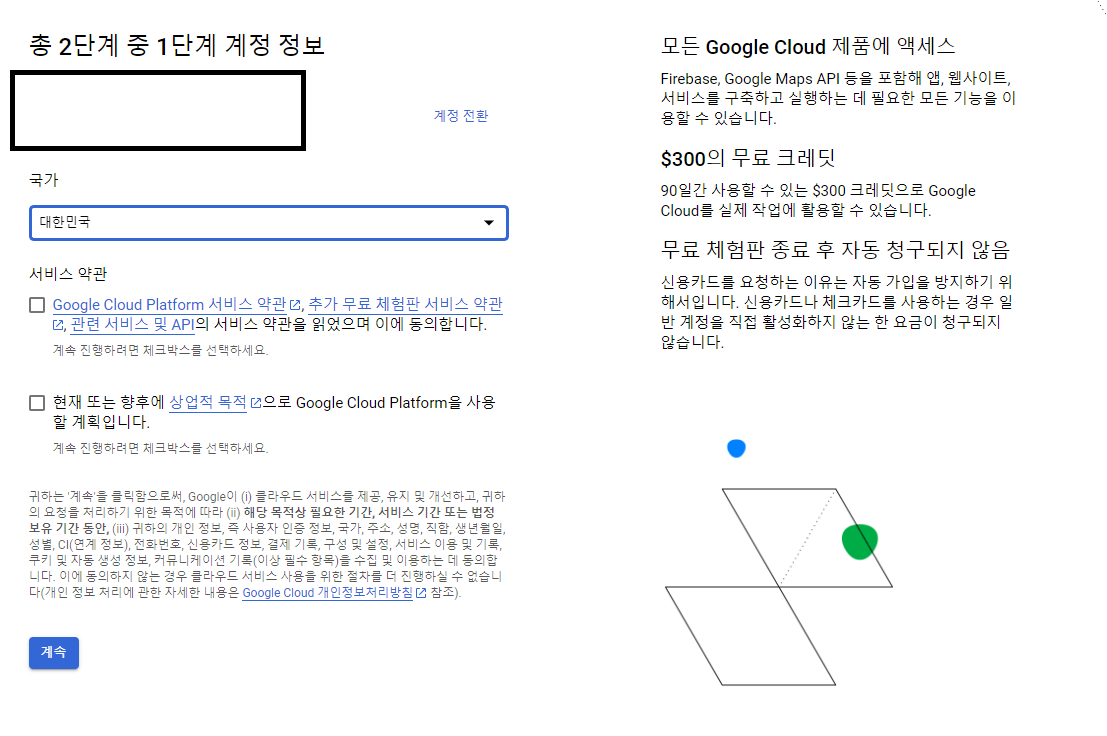

이렇게 나오는데 가입해주시면 $300 크레딧 획득이 가능합니다.

이거도 대충 입력하시면 끝

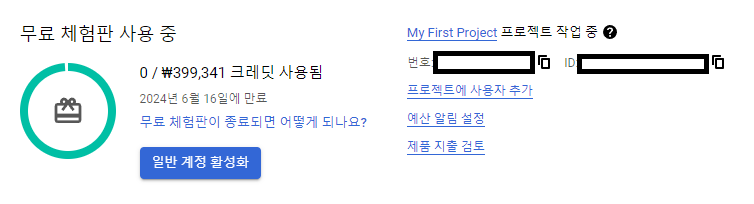

그럼 이런게 나오게 됩니다.

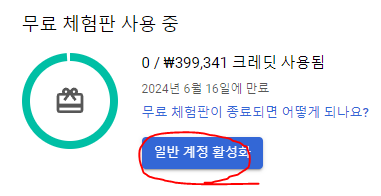

위의 일반 계정 활성화를 눌러주시고

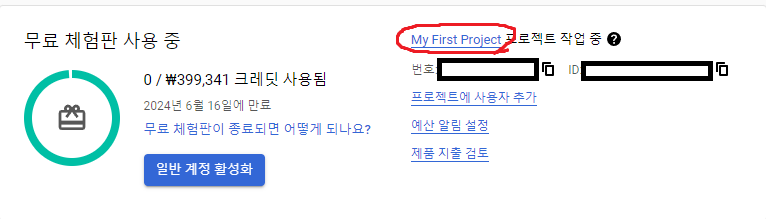

그 다음엔 My First Project를 눌러주시구요.

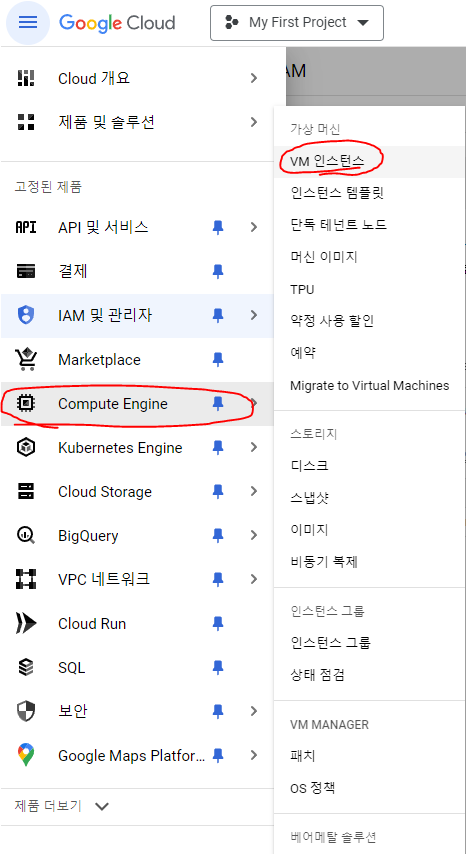

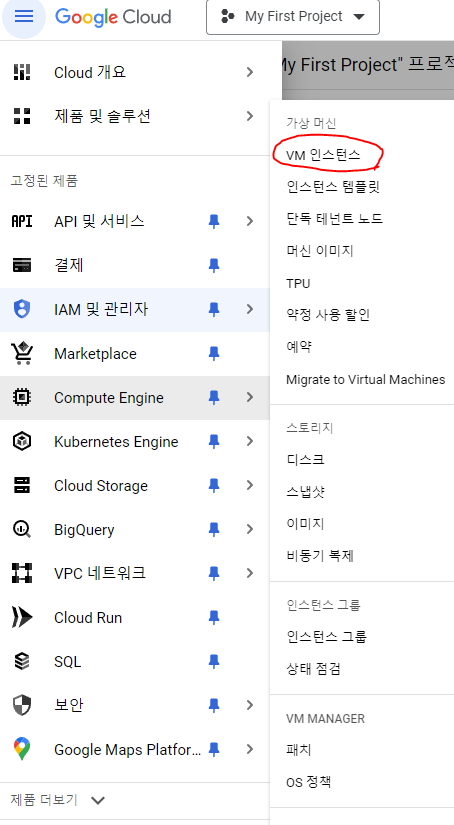

위에 보이는 Compute Engine을 눌러주시고 VM 인스턴스를 눌러주세요.

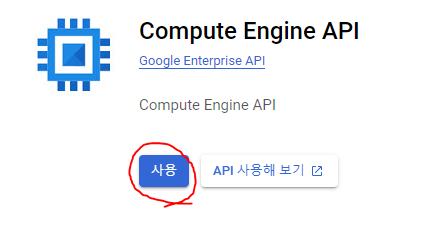

그리고 "사용"이라는 버튼을 클릭해주시고 기다려주시면

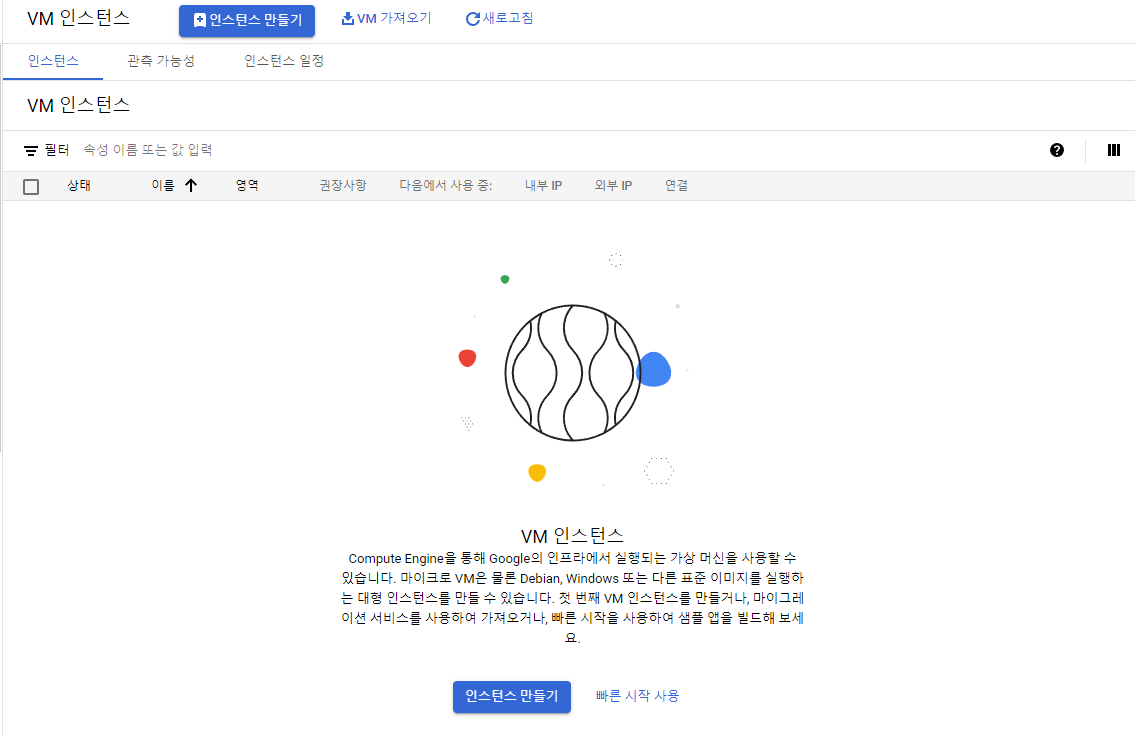

이렇게 나올거에요.

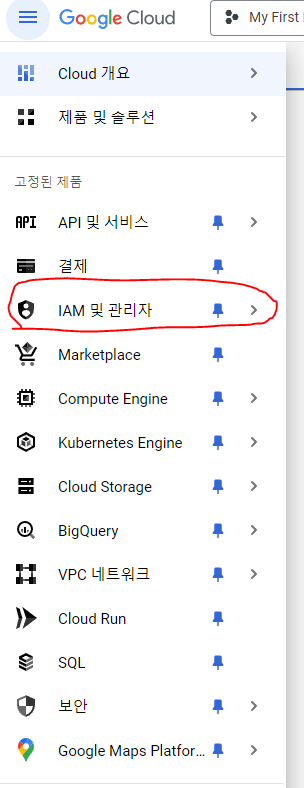

그 다음에 다시 왼쪽 상단의 줄 세개(탐색)을 눌러서

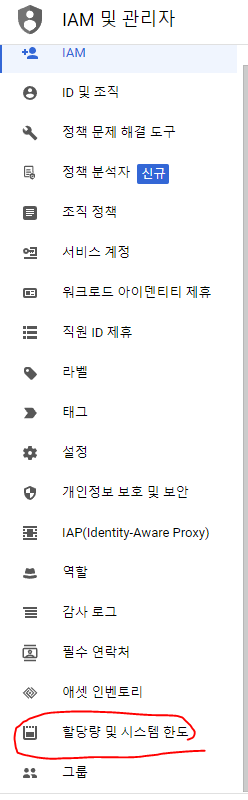

위에 보이는 IAM 및 관리자를 눌러주시고

다시 왼쪽 보시면 할당량 및 시스템 한도라고 있는데 여길 눌러주세요.

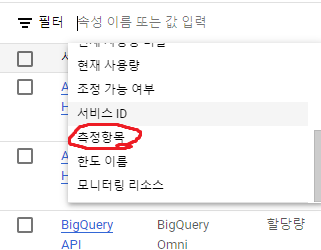

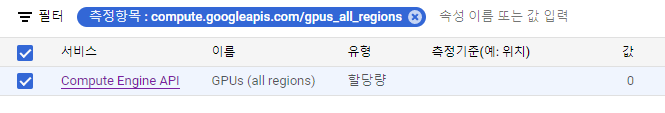

그 다음 필터에

이 측정항목을 선택한 후

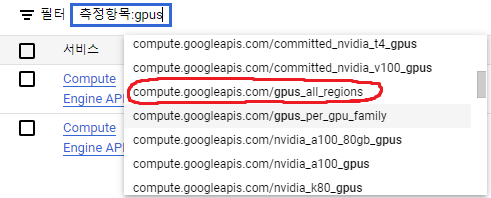

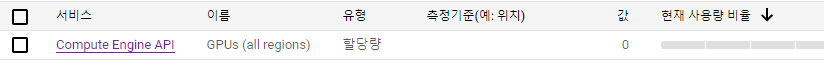

gpus라고 치면 위와 같이 나오는걸 선택하시면 됩니다.

만약 안나오면 5분정도 뒤에 새로고침한 뒤 진행하시면 됩니다.

gpus_all_regions를 넣고 검색해서

체크한 다음

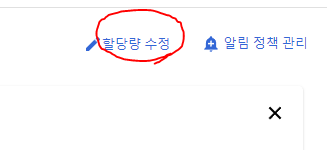

우측의 할당량 수정을 눌러서

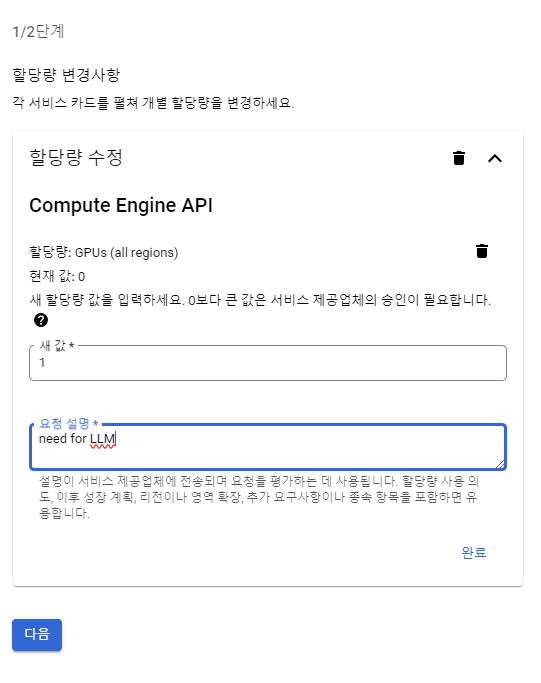

위 처럼 입력하고 다음 눌러서 정보입력한 뒤 요청제출 눌러주세요.

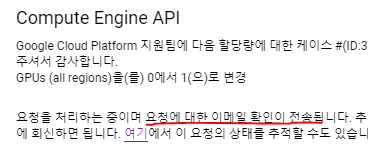

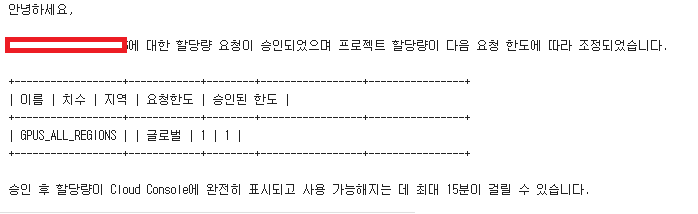

대충 이메일로 전송된다고 하는데, 이메일로 요청이 승인되면 이제 다음 내용을 진행하면 됩니다.

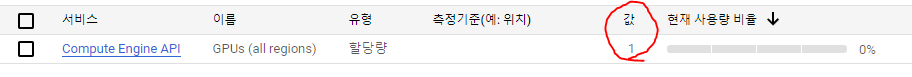

변경됐나 확인은 다시 들어가서 조회해보면 값이 1로 변경되면 끝!

아무튼 이제 GPU사용신청도 됐으니 GPU붙이러 가보겠습니다.

2. GCP에 GPU붙이기

Compute Engine - VM인스턴스를 눌러주세요

인스턴스 만들기를 선택해주시고

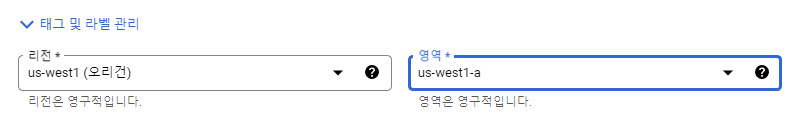

위 리전은 예시이지만 저희는 T4라는 GPU를 사용할 것이기 때문에

반드시 위 영역을 맞춰주세요!

더 많은 영역은 여기서 확인 가능!

GPU 리전 및 영역 가용성 | Compute Engine 문서 | Google Cloud

의견 보내기 GPU 리전 및 영역 가용성 컬렉션을 사용해 정리하기 내 환경설정을 기준으로 콘텐츠를 저장하고 분류하세요. 이 문서에서는 리전 및 영역별로 GPU 모델의 가용성을 설명합니다. GPU를

cloud.google.com

그래야 T4라는 GPU를 사용할 수 있습니다.

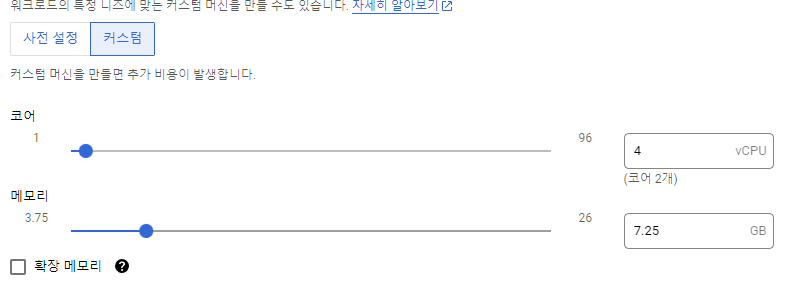

그리고 아래 사전 설정이 아니라 커스텀으로 위처럼 변경하시고

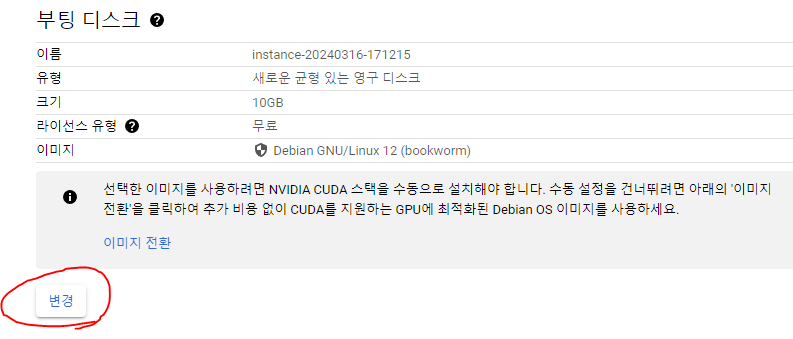

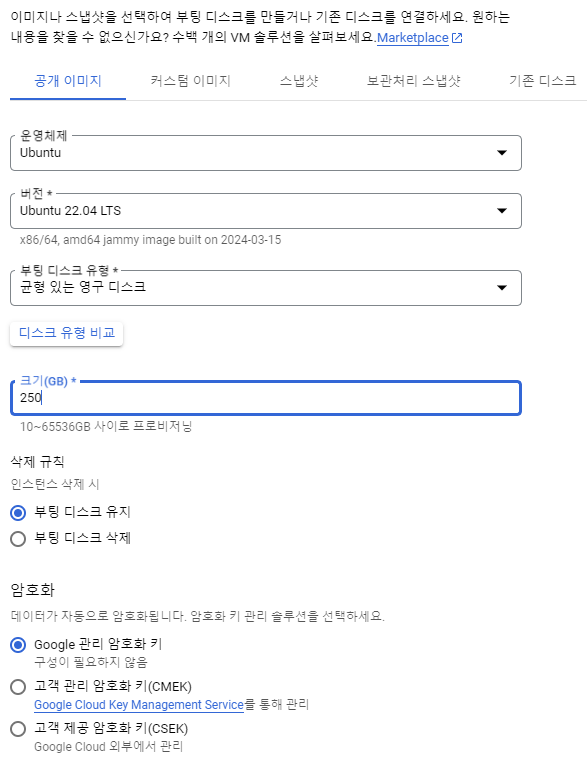

아래로 내려서 부팅디스크 변경을 눌러서

이렇게 따라서 셋팅하시고 선택 누르시면 됩니다.

용량은 최소 250기가 이상해주세요

☞이거 용량때문에 3번 재설치함;;

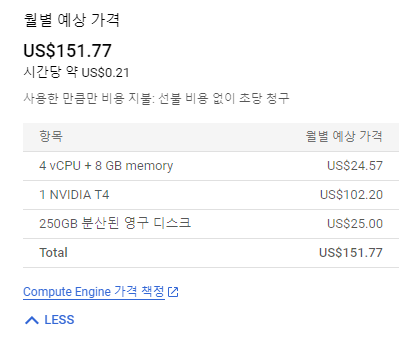

그리고 마지막으로 VM프로비저닝모델은 스팟으로 변경!

그럼 이렇게 무료 크레딧 $300으로 한 달은 쓸 수 있겠죠!

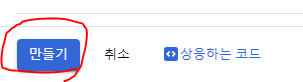

이제 하단의 만들기를 눌러주세요.

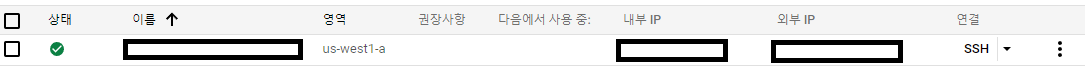

그럼 이렇게 생성완료!

왜 저 GPU를 사용하냐면

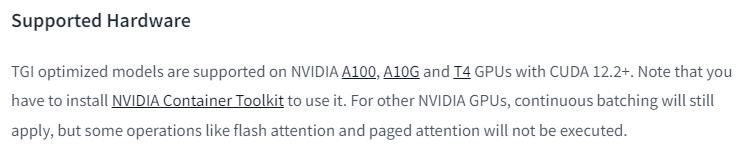

Heurist의 노드를 돌릴 때 필요한 TGI가 지원되는게 위에 나오듯이 Nvidia A100, A10G, T4라고 하는데요.

☞물론 Heurist의 공식피셜로는 12GB 이상의 VRAM을 지원만하면 된다고 하기 때문에 3080Ti급 이상부터는 가능합니다.

그 중 우리는 T4를 최소 1달 공짜로 쓸 수 있기 때문에 이걸 쓴다! 라고 보시면 되겠습니다.

하지만 중요한 점은 관리를 직접 해주셔야되기 때문에 크레딧 잔액이 동나면 자동청구가 되는 방식은 아니지만,

혹시 자동청구가 될 수도 있고 그 안의 파일들을 삭제를 해주는게 안전할 수 있기 때문에

그 전에 미리 해당서버를 삭제해주시는 것도 저는 추천드립니다.

아무튼 이렇게 생성이 되었다면 이제

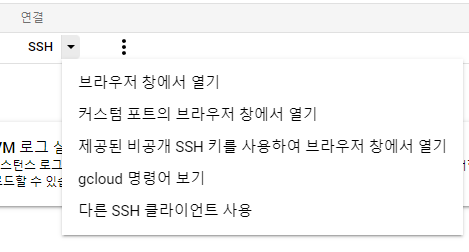

위의 SSH를 눌러서 연결(브라우저 창에서 열기 클릭)하시거나 IP주소를 통해 연결하셔도 됩니다.

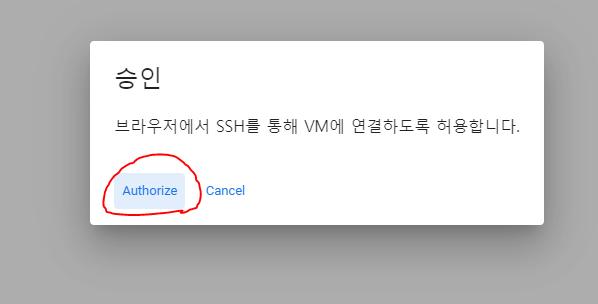

이거 클릭하시고

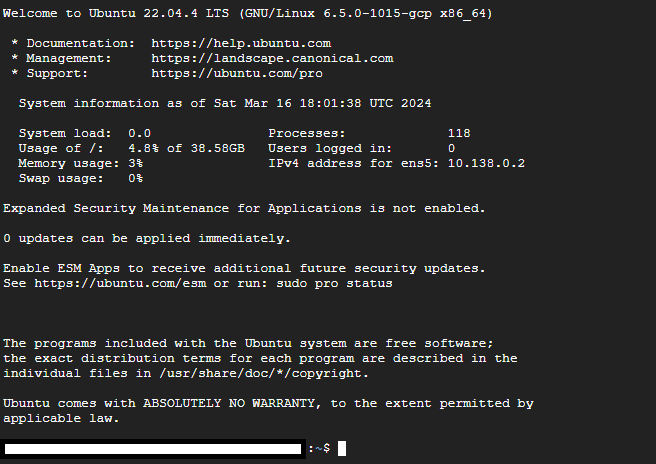

이렇게 로그인된거 확인!!

이제 노드 돌리러 갑시다!

3. Heurist LLM 노드 돌리기 - 설치편

Heurist LLM 노드는 아래의 깃헙에 나와있는대로만 해주시면 되는데요.

https://github.com/heurist-network/miner-release?tab=readme-ov-file#llm-miner-guide-linux

GitHub - heurist-network/miner-release

Contribute to heurist-network/miner-release development by creating an account on GitHub.

github.com

이제 하나하나 설치하겠습니다.

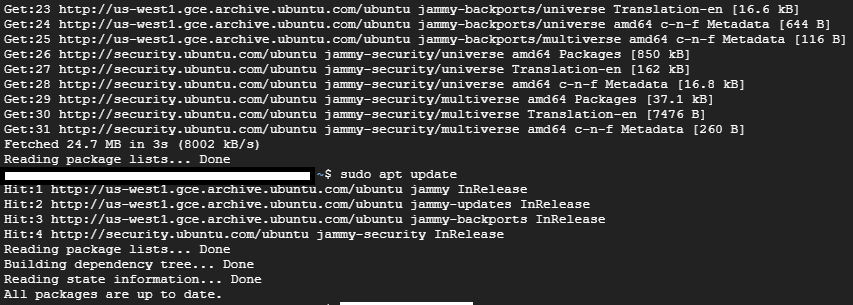

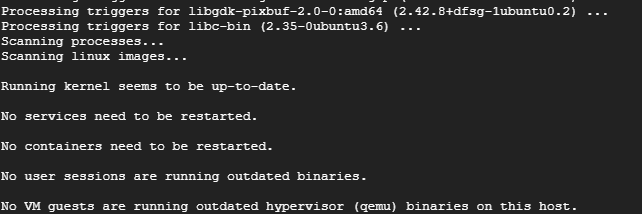

항상 하던거죠? 기초셋팅 업데이트 해줍시다

sudo rm /var/lib/dpkg/info/*

sudo dpkg --configure -a

sudo apt-get update

sudo apt update그 다음 위 명령어로 작업을 하나 해주시구요.

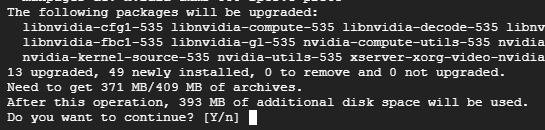

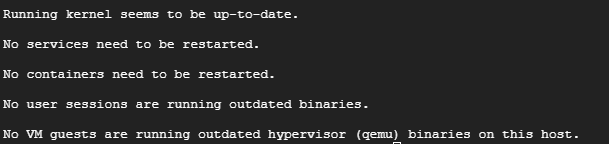

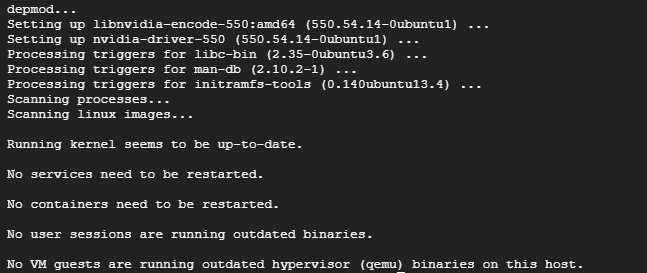

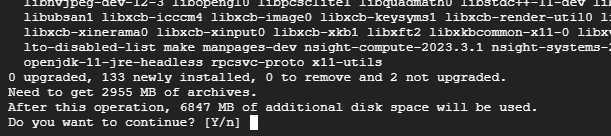

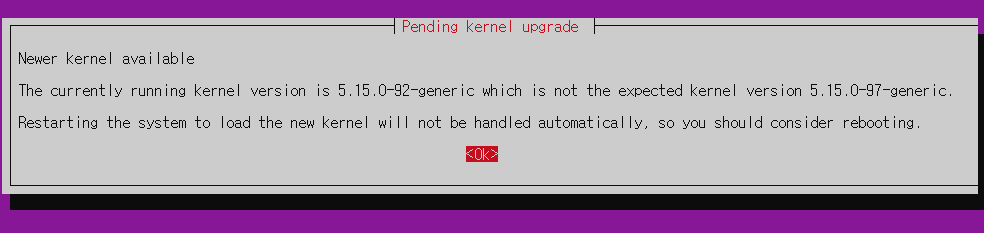

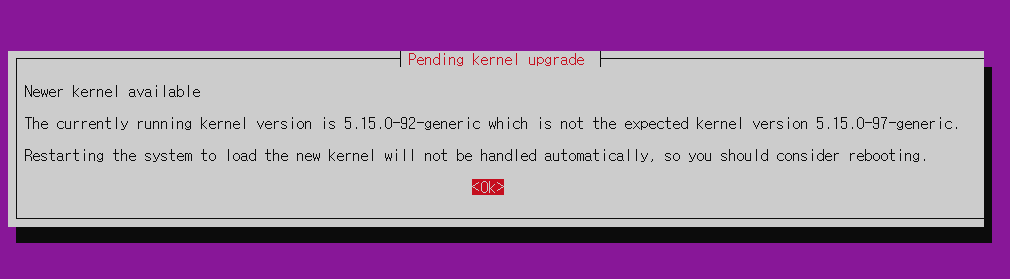

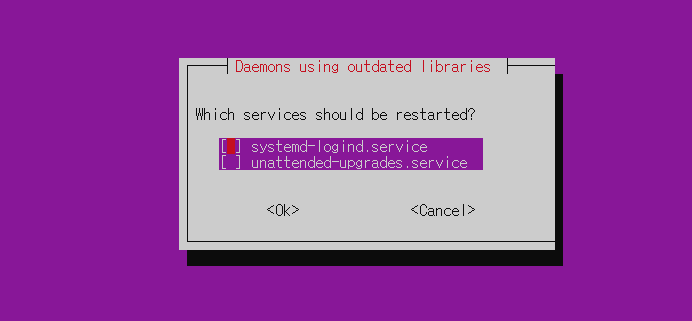

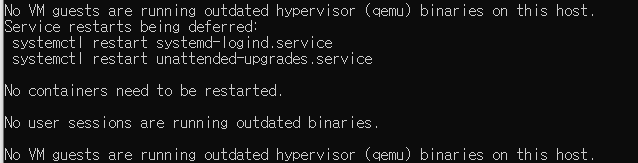

sudo apt upgrade위 명령어도 한 번 수행해주세요. 아래처럼 안나와도 돼요.

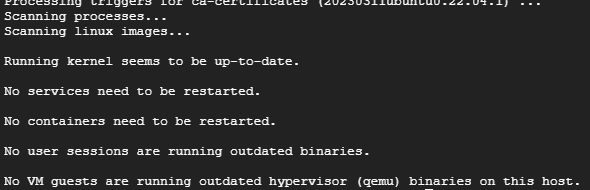

어차피 나중에 아래처럼 나오게 되어있습니다.

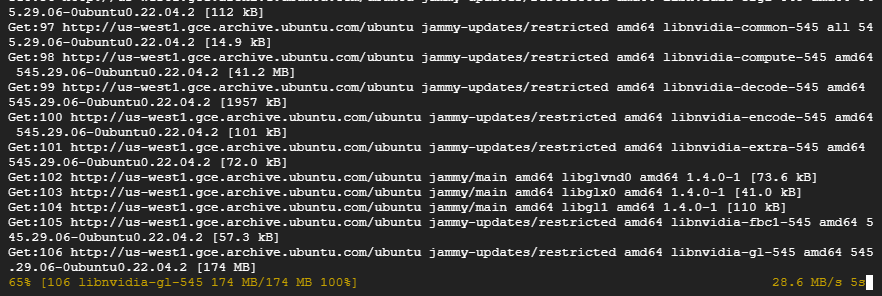

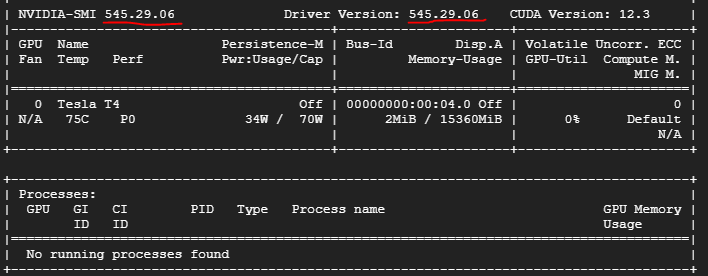

이제 GPU 드라이버를 설치해줍시다.

NVIDIA_DRIVER_VERSION=$(sudo apt-cache search 'linux-modules-nvidia-[0-9]+-gcp$' | awk '{print $1}' | sort | tail -n 1 | head -n 1 | awk -F"-" '{print $4}')위 명령어 그대로 붙여넣기 하시고

echo $NVIDIA_DRIVER_VERSION위 명령어로 버전을 확인합니다.

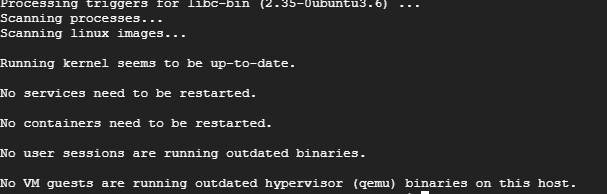

sudo apt install linux-modules-nvidia-${NVIDIA_DRIVER_VERSION}-gcp nvidia-driver-${NVIDIA_DRIVER_VERSION}위 명령어로 드라이버 설치해줍니다.

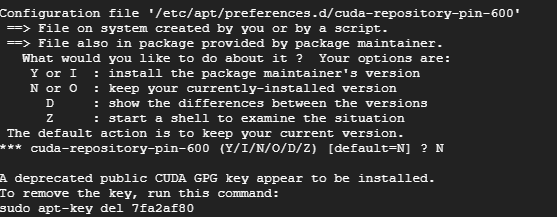

위 화면이 나왔다면

sudo nvidia-smi위 명령어 입력해서

드라이버 버전이 아까 545와 같은지 확인해주시구요.

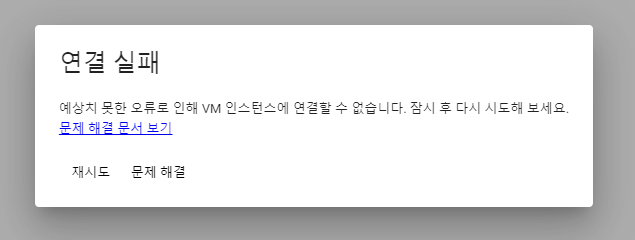

sudo reboot위 명령어로 재부팅해주세요

위 화면으로 바뀌면 1분정도 뒤에 재시도 눌러주면 됩니다.

그리고 다시

NVIDIA_DRIVER_VERSION=$(sudo apt-cache search 'linux-modules-nvidia-[0-9]+-gcp$' | awk '{print $1}' | sort | tail -n 1 | head -n 1 | awk -F"-" '{print $4}')위 명령어 그대로 붙여넣기 하시고

echo $NVIDIA_DRIVER_VERSION위 명령어로 버전을 확인합니다.

그럼 이제

sudo tee /etc/apt/preferences.d/cuda-repository-pin-600 > /dev/null <<EOL

Package: nsight-compute

Pin: origin *ubuntu.com*

Pin-Priority: -1

Package: nsight-systems

Pin: origin *ubuntu.com*

Pin-Priority: -1

Package: nvidia-modprobe

Pin: release l=NVIDIA CUDA

Pin-Priority: 600

Package: nvidia-settings

Pin: release l=NVIDIA CUDA

Pin-Priority: 600

Package: *

Pin: release l=NVIDIA CUDA

Pin-Priority: 100

EOL위 내용 전체 한 번에 복사하고 붙여넣기

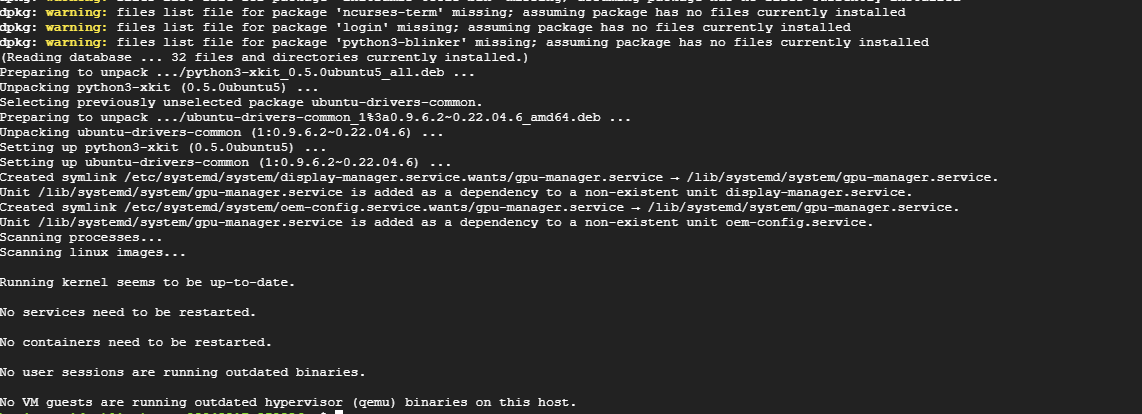

sudo apt install software-properties-common위 명령어 실행해주시면 됩니다.

아래의 방법도 있다고는 하니 참고하시지만 저는 잘 안되서 위의 방법으로 했습니다.

sudo apt install -y ubuntu-drivers-common

위 명령어 입력해서 설치해준 뒤

sudo ubuntu-drivers autoinstall이제 위 명령어 입력해서 드라이버 설치해주시고

그럼 이렇게 나오면서 끝납니다.

하지만 비추천!!

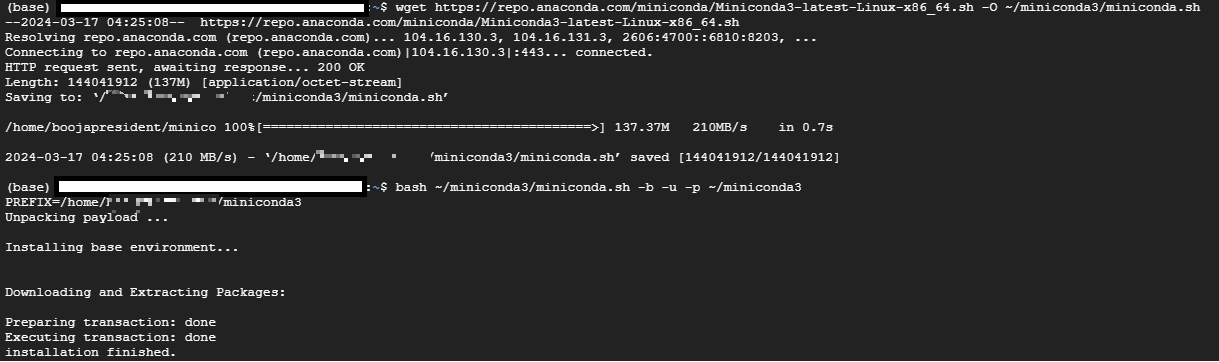

이제 miniconda를 설치해줄거에요.

mkdir -p ~/miniconda3

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh -O ~/miniconda3/miniconda.sh

bash ~/miniconda3/miniconda.sh -b -u -p ~/miniconda3

rm -rf ~/miniconda3/miniconda.sh위 명령어 그대로 한 줄씩 복사해서 수행해주시구요.

~/miniconda3/bin/conda init bash위 명령어도 수행해주세요.

그 다음에

sudo reboot위 명령어로 재부팅해주세요

위 화면으로 바뀌면 1분정도 뒤에 재시도 눌러주면 됩니다.

그리고 다시

NVIDIA_DRIVER_VERSION=$(sudo apt-cache search 'linux-modules-nvidia-[0-9]+-gcp$' | awk '{print $1}' | sort | tail -n 1 | head -n 1 | awk -F"-" '{print $4}')위 명령어 그대로 붙여넣기 하시고

echo $NVIDIA_DRIVER_VERSION위 명령어로 버전을 확인합니다.

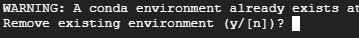

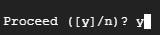

conda create --name gpu-3-11 python=3.11그리고 위 명령어 입력해주시고

conda activate gpu-3-11이거 해주시면

이렇게 바뀝니다.

1) 홈페이지 명령어를 통해 설치하기 - 비추천

저는 개인적으로 아래의 2번의 방식을 추천합니다.

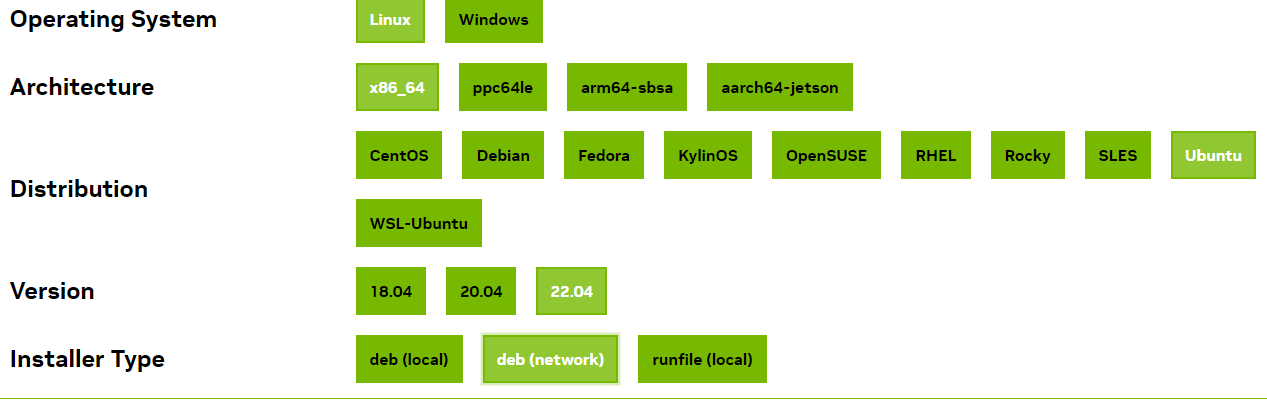

https://developer.nvidia.com/cuda-12-1-0-download-archive

CUDA Toolkit 12.1 Downloads

developer.nvidia.com

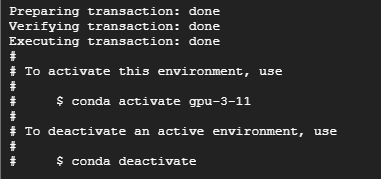

이제 위 사이트에 들어와서

이렇게 눌러주시면

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.0-1_all.deb

sudo dpkg -i cuda-keyring_1.0-1_all.deb

sudo apt-get update

sudo apt-get -y install cuda

이렇게 나오는데요. 위 명령어를 한 줄씩 클릭해주시면 됩니다.

하지만 전 아래 2번의 다른 방식을 더 추천합니다.

만약 다른 부분이 있으면 위 사이트 들어가서 직접 눌러서 해주시면 됩니다.

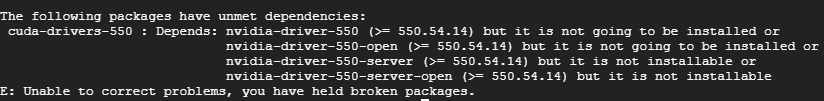

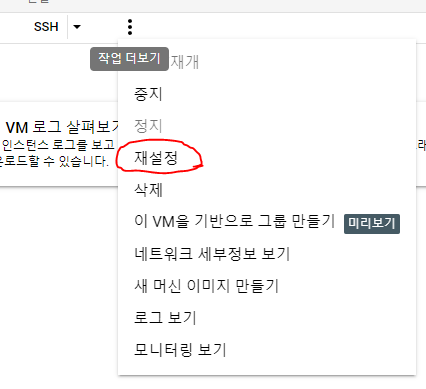

아마 초반에 이렇게 뜨시는 분들이 많을텐데요.

여기 재설정을 누른뒤에 3번 설치편의 처음부터 다시 진행해주시면 스무스하게 아래처럼 진행됩니다.

그래야지만 진행되는게 순서가 맞으니까 안된다고 걱정노노!!

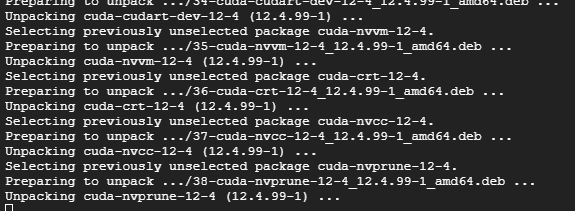

그럼 이런식으로 설치가 쭉쭉 진행되고... 좀 기다리시면

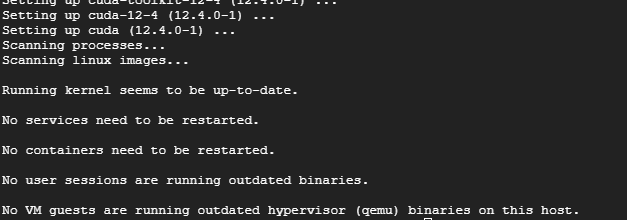

이렇게 나오면서 끝

2) GCP 가이드에서 나온 설치방법 따라하기 - 추천

export UBUNTU_VERSION=ubuntu2204/x86_64이거 해주고

wget https://developer.download.nvidia.com/compute/cuda/repos/$UBUNTU_VERSION/cuda-keyring_1.0-1_all.deb이거 해주고

sudo dpkg -i cuda-keyring_1.0-1_all.deb

sudo add-apt-repository "deb https://developer.download.nvidia.com/compute/cuda/repos/$UBUNTU_VERSION/ /"

위 명령어를 입력해주신 뒤

CUDA_DRIVER_VERSION=$(apt-cache madison cuda-drivers | awk '{print $3}' | sort -r | while read line; do

if dpkg --compare-versions $(dpkg-query -f='${Version}\n' -W nvidia-driver-${NVIDIA_DRIVER_VERSION}) ge $line ; then

echo "$line"

break

fi

done)위 명령어로 엔비디아 드라이버와 맞는 CUDA_DRIVER_VERSION 찾아주고

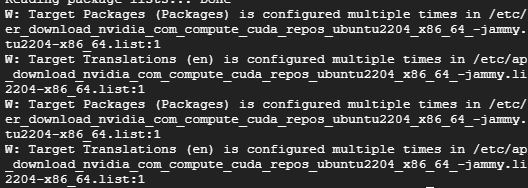

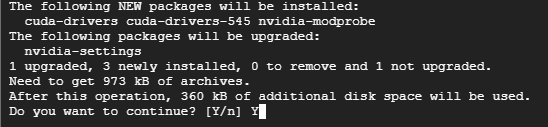

sudo apt install cuda-drivers-${NVIDIA_DRIVER_VERSION}=${CUDA_DRIVER_VERSION} cuda-drivers=${CUDA_DRIVER_VERSION}

위 명령어를 입력하고

CUDA_VERSION=$(apt-cache showpkg cuda-drivers | grep -o 'cuda-runtime-[0-9][0-9]-[0-9],cuda-drivers [0-9\\.]*' | while read line; do

if dpkg --compare-versions ${CUDA_DRIVER_VERSION} ge $(echo $line | grep -Eo '[[:digit:]]+\.[[:digit:]]+') ; then

echo $(echo $line | grep -Eo '[[:digit:]]+-[[:digit:]]')

break

fi

done)위 내용 입력 후

sudo apt install cuda-${CUDA_VERSION}

위 명령어 실행해서 설치해주면 끝납니다.

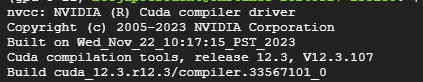

/usr/local/cuda/bin/nvcc --version

그 다음 위 명령어 입력해서 CUDA의 버전을 확인하시면 됩니다.

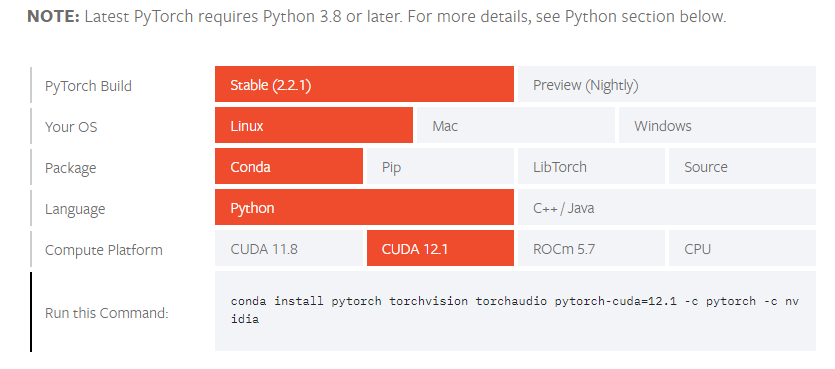

이번엔 pyTorch를 설치해줘야돼요. 이녀석은 딥러닝 필수 오픈소스라 설치해줘야됩니다.

https://pytorch.org/get-started/locally/

Start Locally

Start Locally

pytorch.org

위 사이트 접속하신 뒤

이렇게 눌러야 되구요. 그렇게 나오는 Run this Command를 복사해서 붙여넣고 실행해주세요.

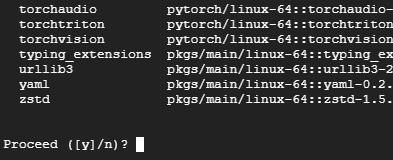

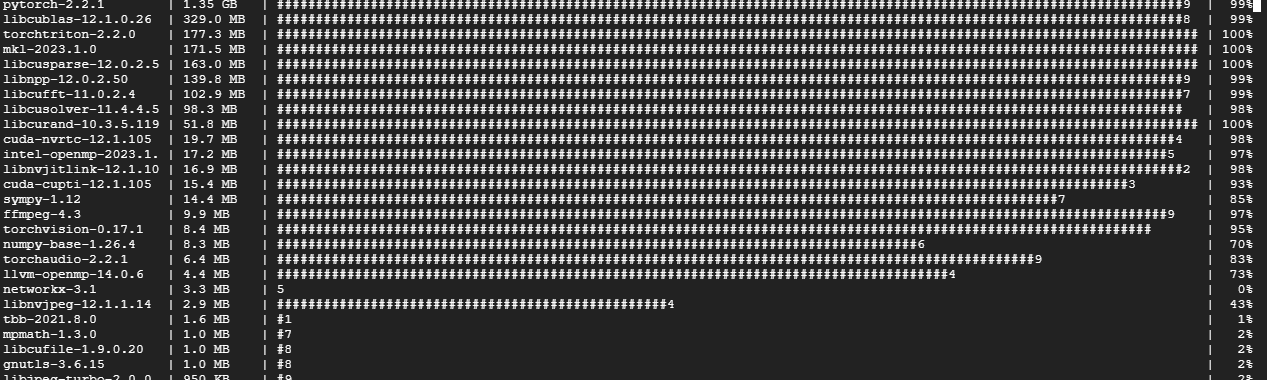

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia귀찮으신 분들은 위 명령어 복붙 ㄱㄱ!

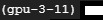

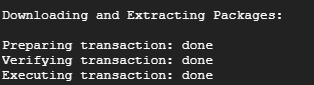

그럼 이렇게 알아서 설치가 진행되고.. 좀 기다리시면

이렇게 뜨면서 끝!

여기까지 됐으면 이제 마지막 설치입니다.

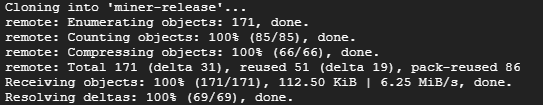

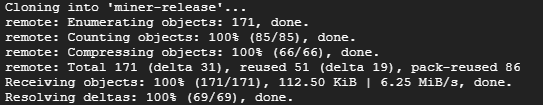

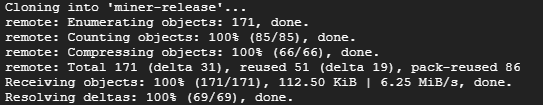

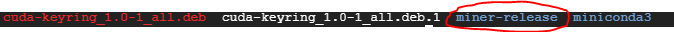

git clone https://github.com/heurist-network/miner-release위 명령어 그대로 입력해서 heurist의 깃을 다운받아줍시다.

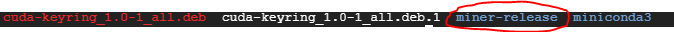

그럼 이렇게 나타날테고

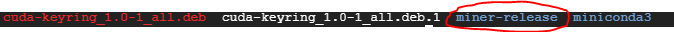

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

이제 환경설정해주러 갑시다.

4. Heurist LLM 노드 돌리기 - 환경설정/수행편

여기까지도 오래걸렸을텐데 모두 수고많으셨습니다. 이제 환경설정해볼게요.

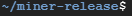

cd miner-release위 명령어 눌러주시구요.

cp .env.example .env위 명령어를 입력한 뒤

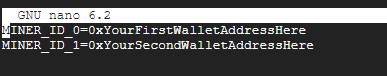

nano .env

로 창을 띄웁니다.

MINER_ID_0=0x로 시작하는 본인EVM주소위 내용을 입력해주세요.

참고하시면, 본인이 쓰는 주소하셔도 되고 새로만든 지갑의 주소하셔도 되지만 화리는 아마 저 지갑주소로 들어갈겁니다.

☞만약 GPU가 여러개면 MINER_ID_0, MINER_ID_1, MINER_ID_2... 이런식으로 갈텐데.. 1개만 했으니 0만 있으면 됩니다.

아무튼 완료되셨다면 Ctrl+X, Y, 엔터를 순차적으로 눌러주세요.

그리고

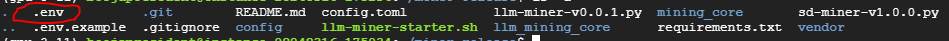

ls -a위 명령어 입력해서

이렇게 .env 파일이 생성됐으면 됩니다.

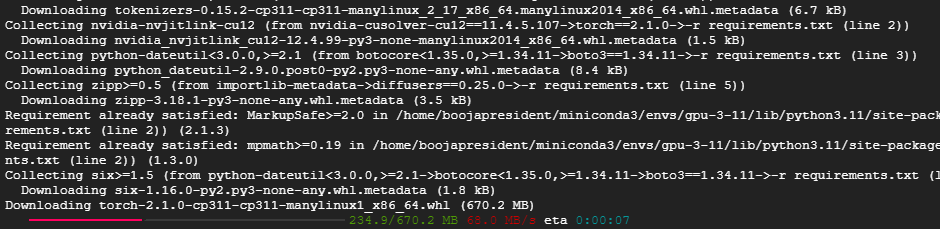

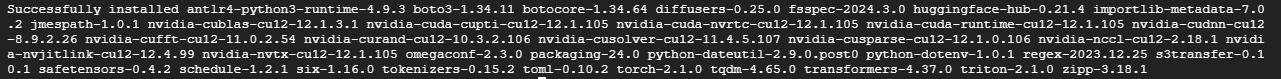

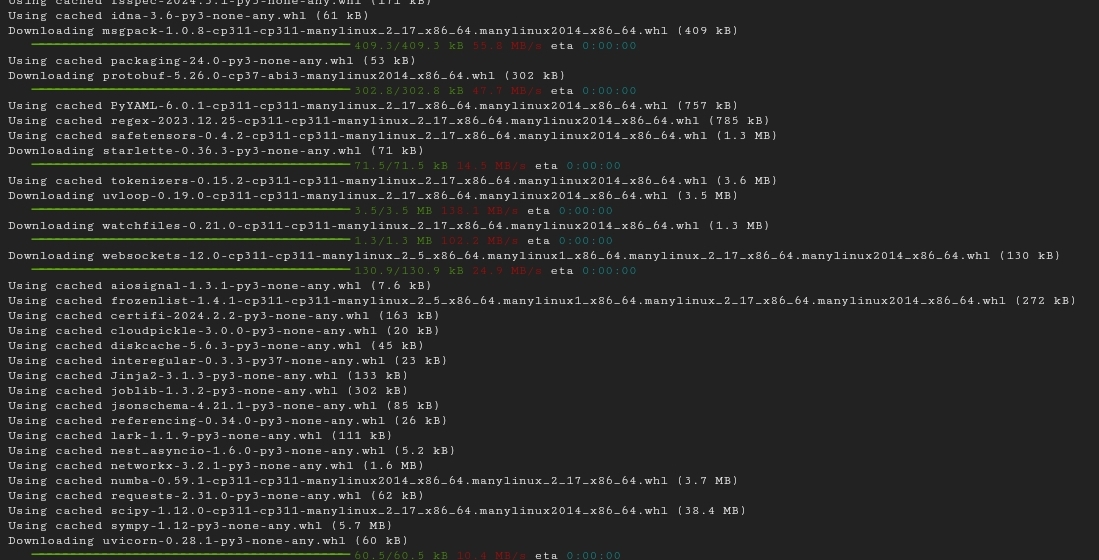

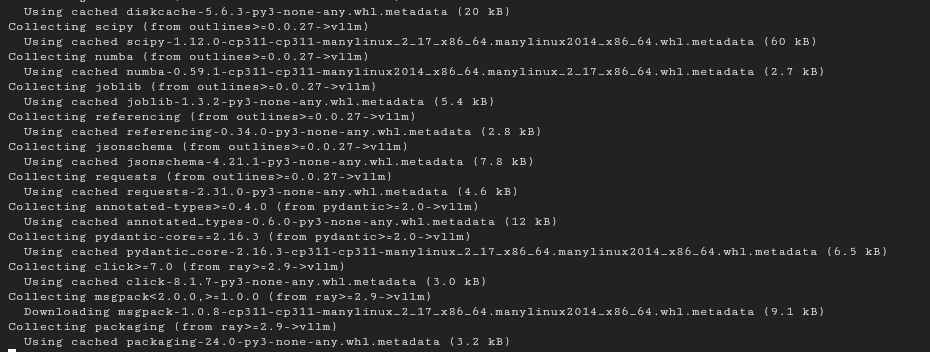

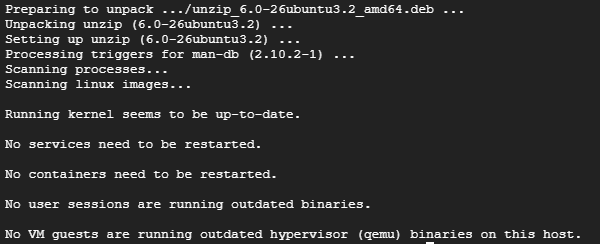

pip install -r requirements.txt이제 위 명령어 입력해서 요구사항을 설치해줍니다.

꼭 현재의 경로가 miner-release에 있는 상태여야 됩니다.

위 내용까지 되셨으면 이제

sudo apt-get install screen위 명령어를 입력해서 screen을 설치해주시고

screen -S heurist를 입력해줍시다.

conda activate gpu-3-11

위 명령어로 앞의 base를 gpu-3-11로 다시 바꿔주시고

그리고

ls를 입력하시고

위의 파일이 있는지 확인하세요.

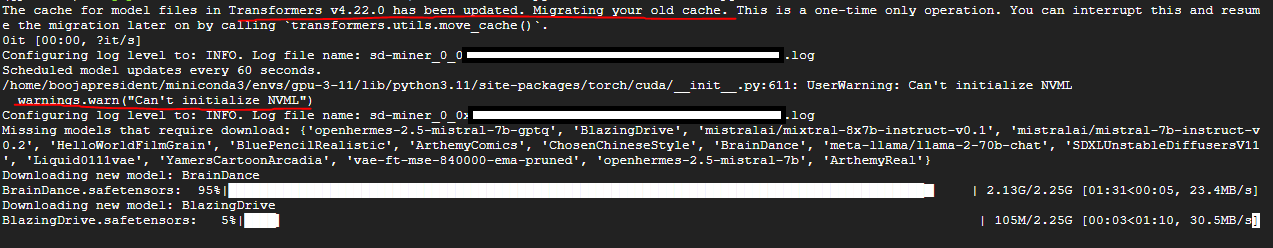

python3 sd-miner-v1.0.0.py이제 위 명령어를 입력해줍시다.

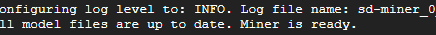

이렇게 나오는거 좀 걸리고, 그 뒤에 알아서 돌아가기 시작할테니 Ctrl+A+D로 빠져나와주세요.

혹시 다시 저 화면에 들어가고 싶으시다면

screen -r heurist위 명령어를 입력해주시면 들어가집니다.

위 방법이 이 9단계까지 완료한 SD 마이너의 노드 구축 방법입니다!

☞이거 계속 돌려놓으면 GCP의 경우엔 트래픽 초과로 접속막힌다고 하니까 일단은 이건 중요하지 않으므로 꺼둡시다!

끄는 방법은

sudo screen -X -S heurist kill해주시면 됩니다.

※3월 20일 이전에 수행하신 분들은 아래의 명령어를 꼭 수행해주세요!

내용이 수정되어 새로운 버전으로 설치해야합니다.

cp ~/miner-release/.env ~/.env

cd ~

rm -rf miner-release위 명령어를 차례차례 수행해주시구요.

git clone https://github.com/heurist-network/miner-release위 명령어 그대로 입력해서 다시 heurist의 깃을 다운받아줍시다.

그럼 이렇게 나타날테고

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

그리고

cp ~/.env ~/miner-release/.env위 명령어를 다시 입력해주시면 환경설정파일까지 모두 복사 붙여넣기 완료!

이제 LLM을 돌리러 가보죠!

5. Heurist LLM 노드 돌리기 - LLM 가이드(마지막) 편

도커를 돌리지 않고 수행하는 방식으로 코드가 변경되었습니다!!!

※3월 20일 이전에 수행하신 분들은 아래의 명령어를 꼭 수행해주세요!

cp ~/miner-release/.env ~/.env

cd ~

rm -rf miner-release위 명령어를 차례차례 수행해주시구요.

git clone https://github.com/heurist-network/miner-release.git위 명령어 그대로 입력해서 다시 heurist의 깃을 다운받아줍시다.

그럼 이렇게 나타날테고

ls위 명령어를 입력해서

위와 같이 miner-release가 나왔으면 정상입니다.

그리고

cp ~/.env ~/miner-release/.env위 명령어를 다시 입력해주시면 환경설정파일까지 모두 복사 붙여넣기 완료!

이전 도커 설치하는 방법이 궁금하시면 참고만 하세요~

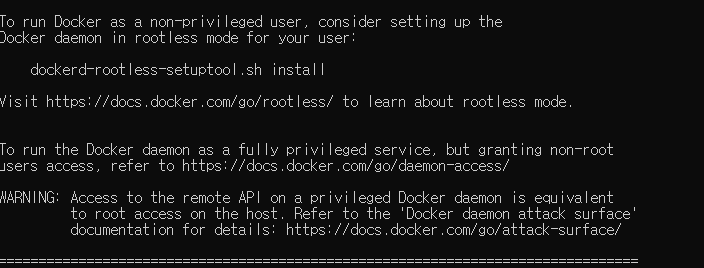

우선 이제 도커를 설치해야되기 때문에 아래의 명령어를 입력해주시기 바랍니다.

sudo apt -qy install curl git lz4 build-essential위 명령어로 build 준비도해주시면 도커 설치준비는 끝입니다.

그리고 Docker 설치해줍니다.

curl -fsSL https://get.docker.com -o get-docker.sh위 명령어를 입력해주셔서 도커를 다운로드 해주시구요. (아무것도 안뜨는게 맞음)

sudo sh get-docker.sh위 명령어로 설치를 해줍니다.

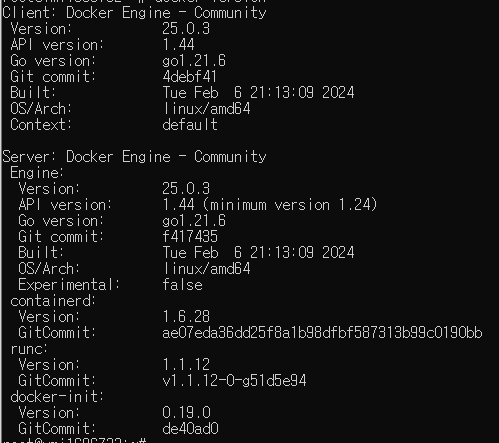

docker version위 명령어로 제대로 설치됐나 한 번 확인해주시고

잘 설치된 것 확인했으니까 이제

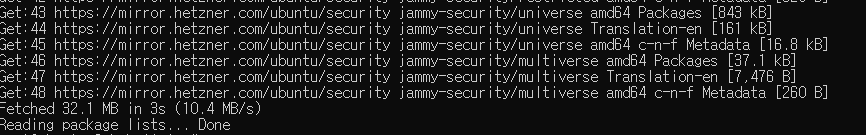

sudo apt-get update위 명령어를 통해 apt-get을 업데이트해주시고

완료되셨다면

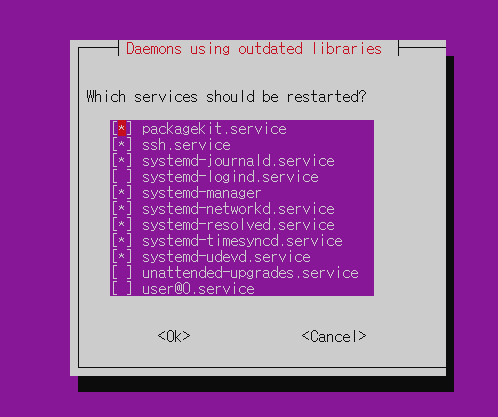

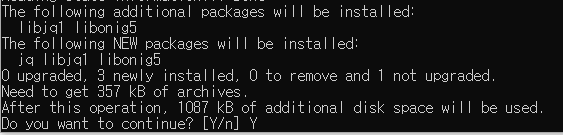

sudo apt install jq이제 docker compose설치해주기 위해 jq를 먼저 설치해주시구요.

두 화면 모두 엔터눌러주시면

이렇게 설치완료가 됩니다.

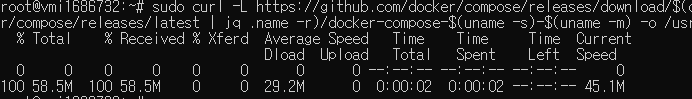

sudo curl -L https://github.com/docker/compose/releases/download/$(curl --silent https://api.github.com/repos/docker/compose/releases/latest | jq .name -r)/docker-compose-$(uname -s)-$(uname -m) -o /usr/bin/docker-compose이제 docker-compose 최신버전으로 설치해주기 위한 명령어 입력해줍시다.

sudo chmod 755 /usr/bin/docker-compose위 명령어 입력해서 권한 높여주시고

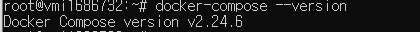

이제 설치가 잘 됐나 확인 한 번 해줍니다.

docker-compose version위 명령어 입력하면

여기까지 되셨으면 이번엔 CUDA Toolkit을 설치해줘야됩니다.

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list위 명령어 한 번에 복사해서 붙여넣어서 실행시켜주신 뒤에

그 다음

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit각 명령어를 한 줄씩 수행해주시면 됩니다.

이제 CUDA Toolkit 셋팅해줘야되는데

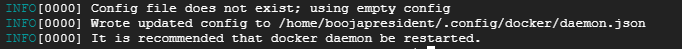

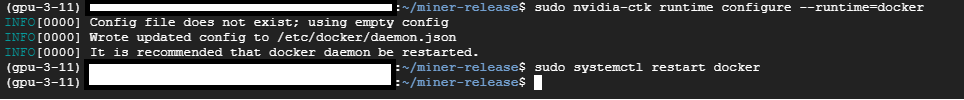

sudo nvidia-ctk runtime configure --runtime=docker

위 명령어 입력하고

sudo systemctl restart docker이거까지 입력해주시면 됩니다.

그리고 Docker가 제대로 실행되는지 확인하려면

docker ps를 입력하시면 되는데 만약 Permission Denied같은 에러가 뜬다면

sudo chmod 666 /var/run/docker.sock위 명령어를 입력한 뒤

docker ps를 입력해주시면 됩니다. (어차피 아무것도 안나올거에요~)

이제 설치가 되었으니

screen -S heurist_LLM위 스크린 생성해준 뒤

conda activate gpu-3-11

위 명령어로 앞의 base를 gpu-3-11로 다시 바꿔주시고

cd miner-release입력해서 경로 바꿔주시고

chmod +x llm-miner-starter.sh

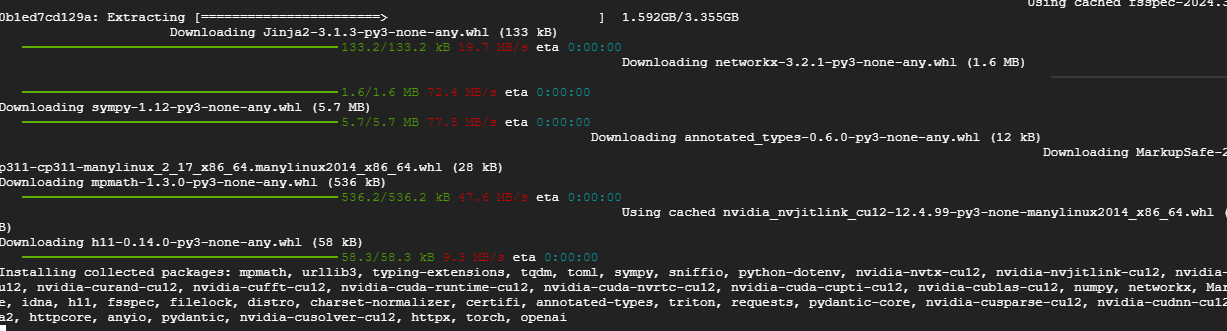

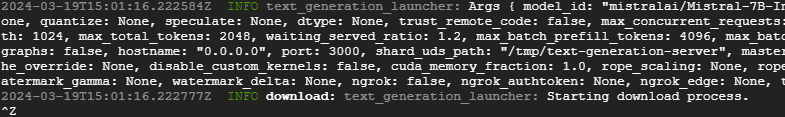

./llm-miner-starter.sh마지막으로 위 명령어 수행해주시면

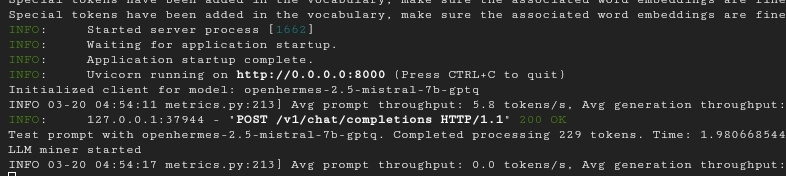

이런 설치가 나옵니다. 한 3~5분정도만 기다리시면

이렇게 정상적으로 작동되는게 확인됩니다!

이제 Ctrl+A+D로 빠져나와주시고 창 닫아주시면 끝!!

만약 다시 접속해서 잘 돌아가나 확인하고 싶으시다면

screen -r heurist_LLM위 명령어를 입력하시면 되고

사이트에서 확인할 경우엔

위 사이트 들어가서 지갑연결하시면 됩니다.

여기까지가 LLM Miner 수행하는 방법이었습니다.

이전보다 훨씬 간단해졌네요 ㅎㅎ

※이전 로컬로 설치하는 방법은 아래를 참고하시면 됩니다.

위 방법대로 했는데 에러가 난다면 한 번 아래의 방식대로 해보셔도 좋을 것 같습니다.

일단 screen을 나가주세요.

exit를 입력하시면 됩니다.

https://github.com/huggingface/text-generation-inference?tab=readme-ov-file#local-install

GitHub - huggingface/text-generation-inference: Large Language Model Text Generation Inference

Large Language Model Text Generation Inference. Contribute to huggingface/text-generation-inference development by creating an account on GitHub.

github.com

이 허깅페이스에 있는 로컬 인스톨을 참조하면 되는데요.

일단 수정부터 해줍시다.

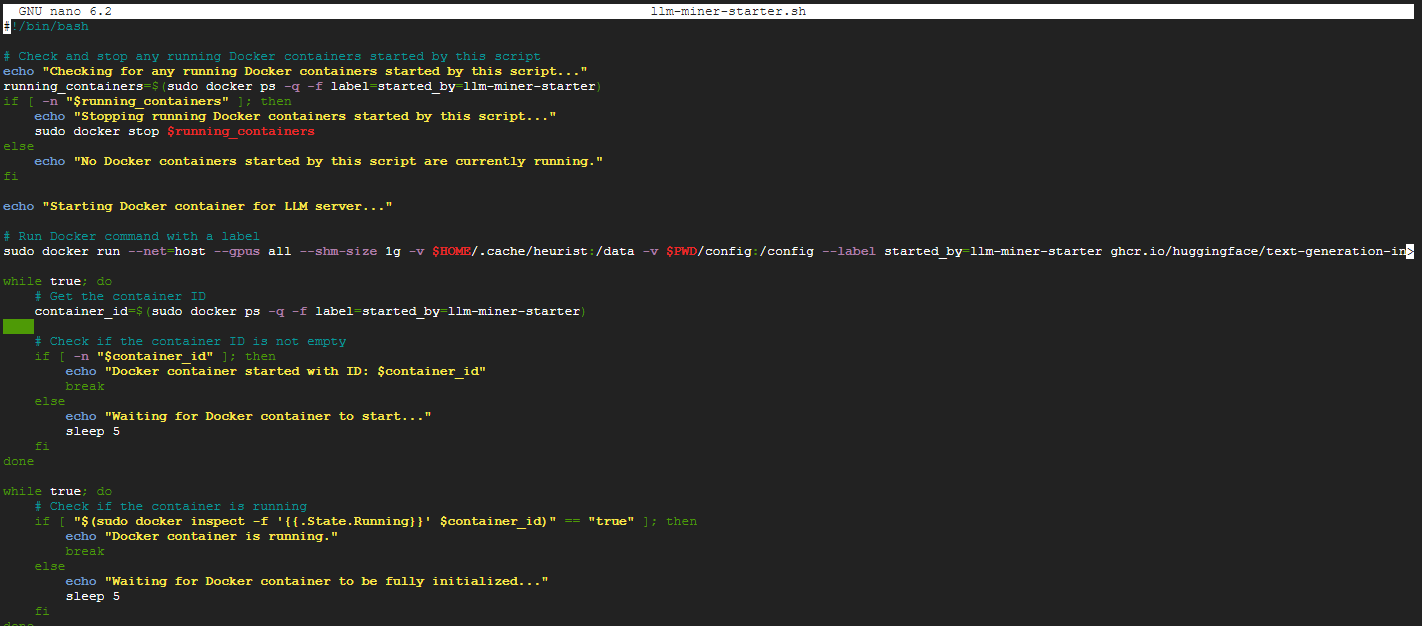

cd ~/miner-release로 눌러서 폴더 변경해주시고

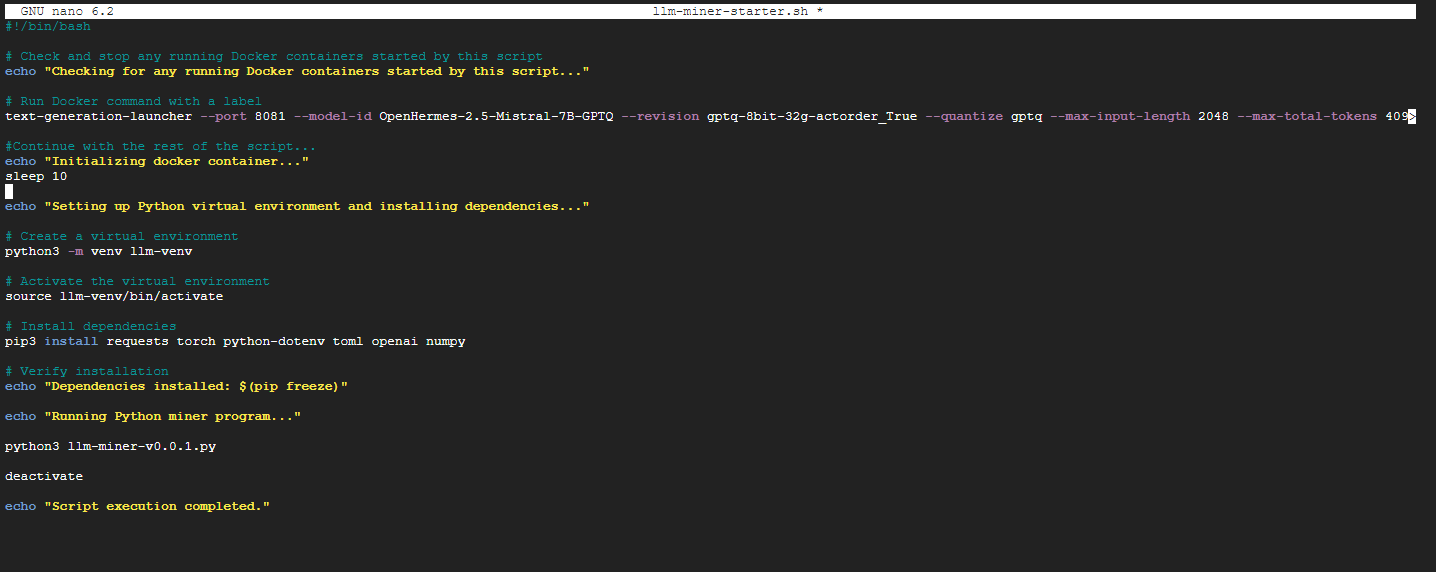

nano llm-miner-starter.sh를 입력해주시고

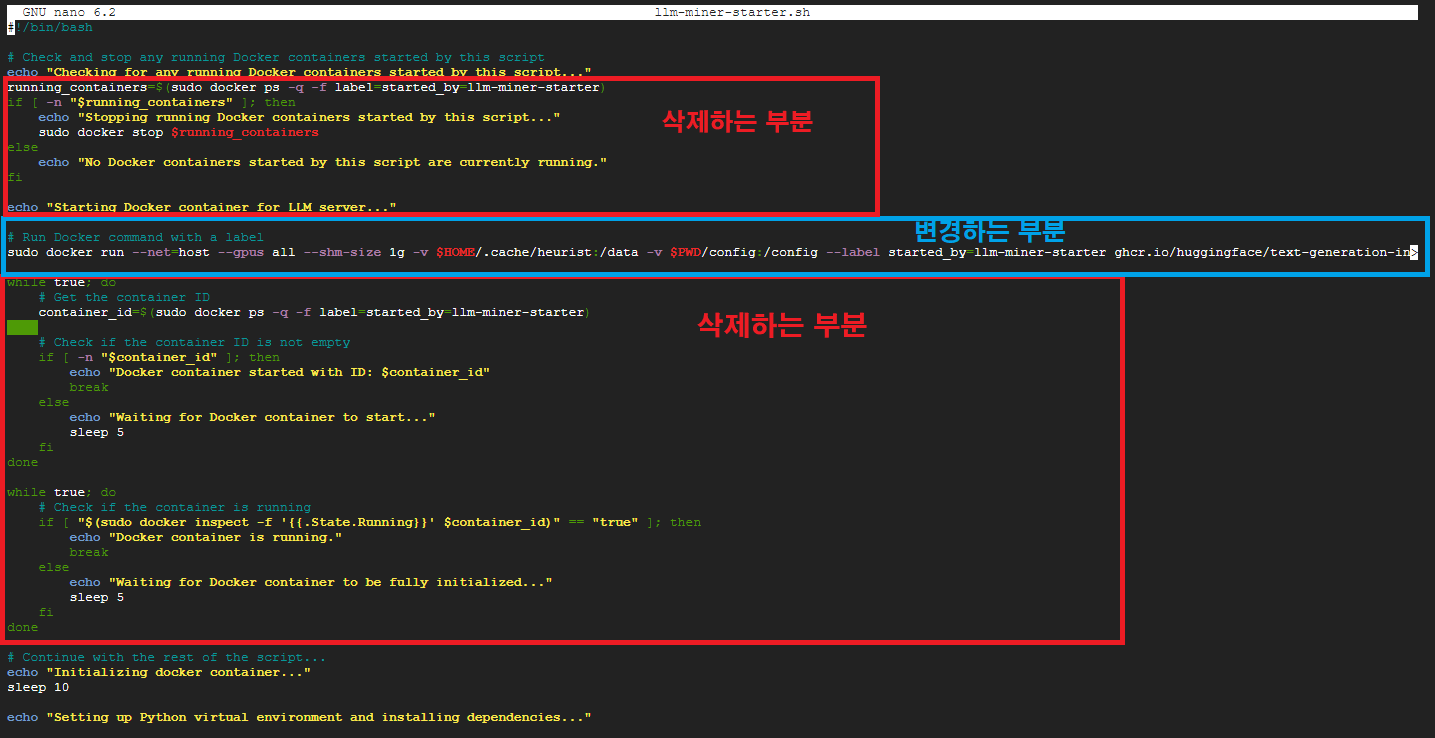

이런식으로 나오는데 지울 곳과 변경될 곳을 표시해드릴테니 그대로 하시면 됩니다.

이렇게 구역을 표시했으니 삭제하는 부분은 지워주시면 되구요.

변경하는 부분

text-generation-launcher --port 8081 --model-id OpenHermes-2.5-Mistral-7B-GPTQ --revision gptq-8bit-32g-actorder_True --quantize gptq --max-input-length 2048 --max-total-tokens 4096 --max-batch-prefill-tokens 4096 --tokenizer-config-path ~/miner-release/config/openhermes_2.5_mistral_7b_tokenizer_config.json --huggingface-hub-cache ~/.cache/heurist &위 내용으로 변경해주시면 됩니다.

※ 변경 스크립트 알려주신 Parna님께 다시 한 번 감사드립니다.

변경하시면 위와 같은 내용으로 확 줄어듭니다.

이걸 어떻게 변경하냐고 묻지마세요.. 복사와 붙여넣기와 del만 하실 줄 알면 가능합니다...

다 되셨으면 Ctrl+X, Y, 엔터를 눌러서 저장해주고 나옵니다.

이제

cd ~위 명령어 수행한 뒤 설치하러 갑니다.

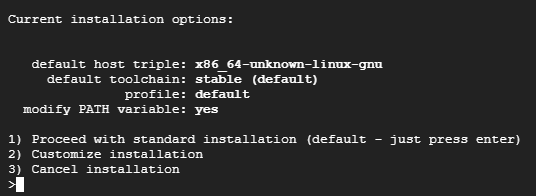

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

conda create -n text-generation-inference python=3.11

conda activate text-generation-inference위 명령어를 한 줄씩 복사해서 붙여넣어서 명령어를 실행해줍시다.

그 다음엔

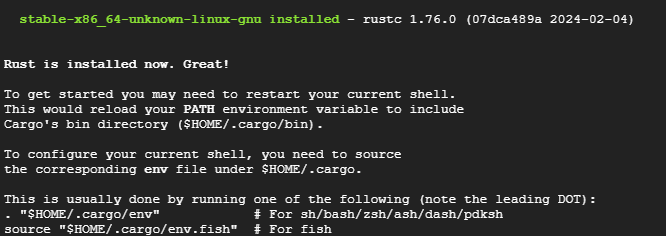

sudo apt install unzip

위 명령어로 unzip을 다운받아주고

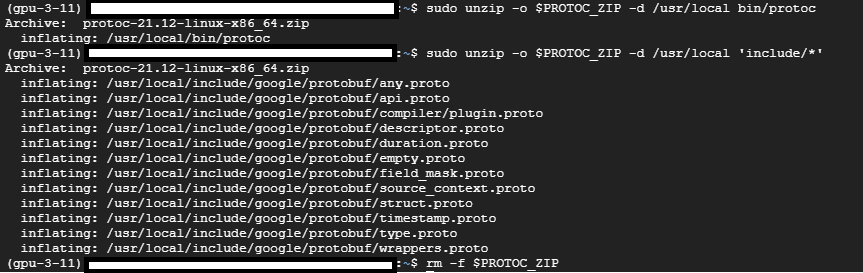

PROTOC_ZIP=protoc-21.12-linux-x86_64.zip

curl -OL https://github.com/protocolbuffers/protobuf/releases/download/v21.12/$PROTOC_ZIP

sudo unzip -o $PROTOC_ZIP -d /usr/local bin/protoc

sudo unzip -o $PROTOC_ZIP -d /usr/local 'include/*'

rm -f $PROTOC_ZIP위 명령어를 한 줄씩 입력해서 실행해줍시다.

최종적으로 이렇게 나오면 됩니다.

이제

git clone https://github.com/huggingface/text-generation-inference.git

sudo apt-get install libssl-dev gcc -y

cd text-generation-inference

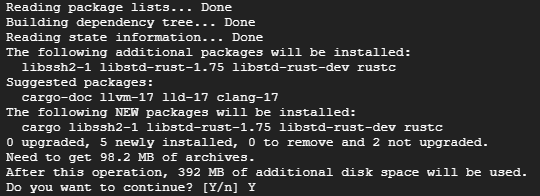

sudo apt install cargo

까지 해주시구요.

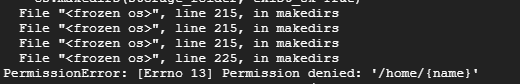

export PATH=/home/폴더명/.cargo/bin:$PATH폴더명이라는 부분에는

네모친 부분의 명칭이 들어갑니다.

pip install transformers이제 위 명령어 입력해주신 뒤

아래의 명령어 수행해주세요.

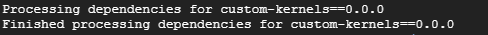

BUILD_EXTENSIONS=True make install

한 20분정도 소요됩니다.

text-generation-launcher --model-id mistralai/Mistral-7B-Instruct-v0.2그리고 위 명령어도 한 줄씩 입력해서 수행되나 확인하고 수행되면 바로 Ctrl+Z 눌러주세요.

cd ~

python

from huggingface_hub import snapshot_download

snapshot_download(repo_id="TheBloke/OpenHermes-2.5-Mistral-7B-GPTQ", revision="bb25559f6049d7c0d101428c6a7575877d5ae333", cache_dir="/home/{name}/.cache/heurist")

snapshot_download(repo_id="TheBloke/OpenHermes-2.5-Mistral-7B-GPTQ", revision="bb25559f6049d7c0d101428c6a7575877d5ae333", cache_dir="/home/{name}/.cache/heurist")위 내용의 뒤쪽에 있는 {name}이라는걸

여기 네모친 부분의 이름으로 넣으면

이렇게 성공합니다.

이제 마지막입니다.

exit()위 명령어로 화면을 빠져나와주신 뒤

screen -S heurist이제 스크린생성해주시고

conda activate text-generation-inference입력해주시고

cd ~/miner-release경로 변경해주시고

./llm-miner-starter.sh위 명령어 실행시켜주세요.

만약 안되고 에러나면 밀고 다시 시작하기!!

일단 여기까지가 Heurist 노드 구축하기 끝!

여기가지가 Heurist LLM 작업방법이었습니다!

아무튼 일단 확인된 바는 여기까지만 가능하니 참고하시구요!

작업하다 막히거나 모르시는 부분이 발생한다면 댓글이나 텔레그램을 통해 질문주시면 알려드릴게요!

소식과 내용을 빠르고 다양하게 접하고 싶으시다면 아래 그림(텔레그램)을 클릭해주세요!!

'크립토 에어드랍 작업 > 노드 운용하기' 카테고리의 다른 글

| 휴리스트(Heurist) AI Incentivized Testnet(인센티브 테스트넷) 작업 시작! (29) | 2024.04.01 |

|---|---|

| 바이낸스가 투자한 Nimble, 노드 돌려보기! Feat. Vast.ai (5) | 2024.03.28 |

| 다시 돌아온 Taiko 노드 완벽정리! (20) | 2024.03.10 |

| 바빌론 노드 작업하는데 계속 에러나요! 어떻게 해야돼죠? (8) | 2024.03.07 |

| Ritual 노드 돌려보자! 아니 그냥 돌리세요. AI입니다.(Renewal 완료) (297) | 2024.03.02 |